🤗

【簡単】DeepSeek R1 ローカルで使う GPUなしで CPUのみ

話題のDeepSeek

ブラウザ版とAndroid版のを普段から使ってきていたが,なんせ中国の会社なので突然サービス終了したりするかもっと思ったので(根拠ない),ローカルで動かしてみたかった.

自分の環境は 独立GPUなし i5-1340p(AVX2命令セット対応)16GB RAM

Ubuntuの場合は以下の記事をご覧下さい.

LM studioをインストール.

まずは,LM studioをインストール.いろんなLocall LLMが動かせるやつです.

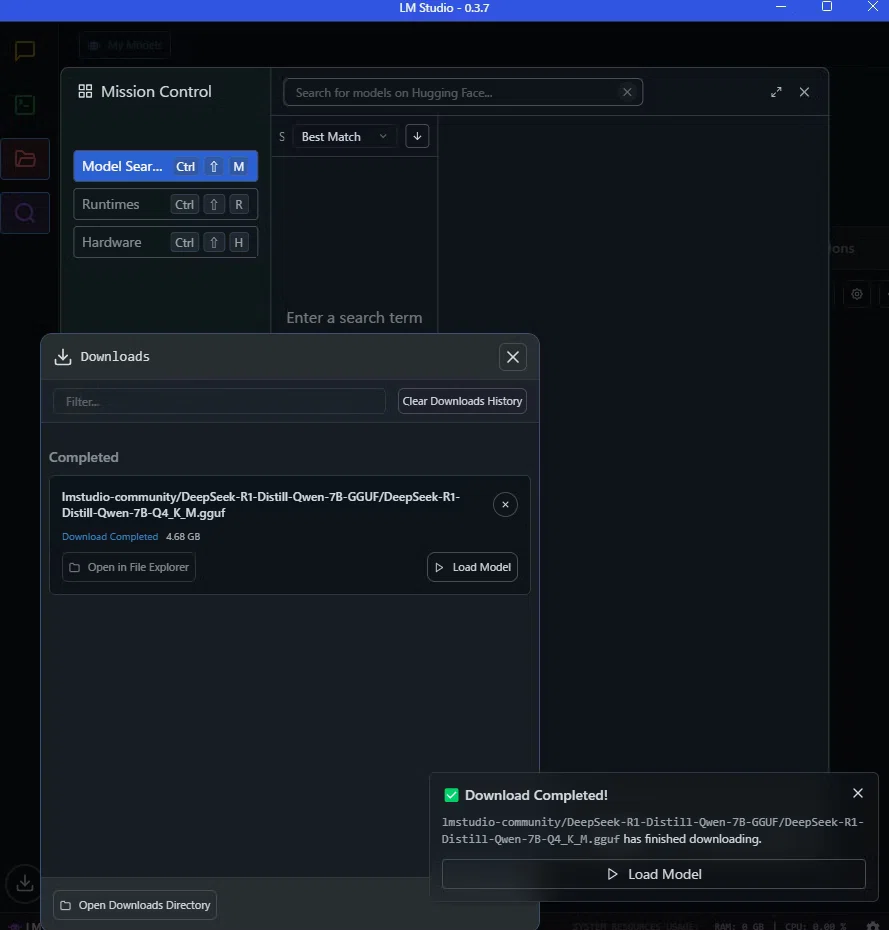

適当なモデルを選んでダウンロード

”Download and run DeepSeek R1 Distill (Qwen 7B)”をクリックして,LM studioで開くだけ

(これはDeepSeek-R1ですが、CPUなしでも動く軽めのモデルです)

ダウンロードが完了したら

Load Modelってのをクリック

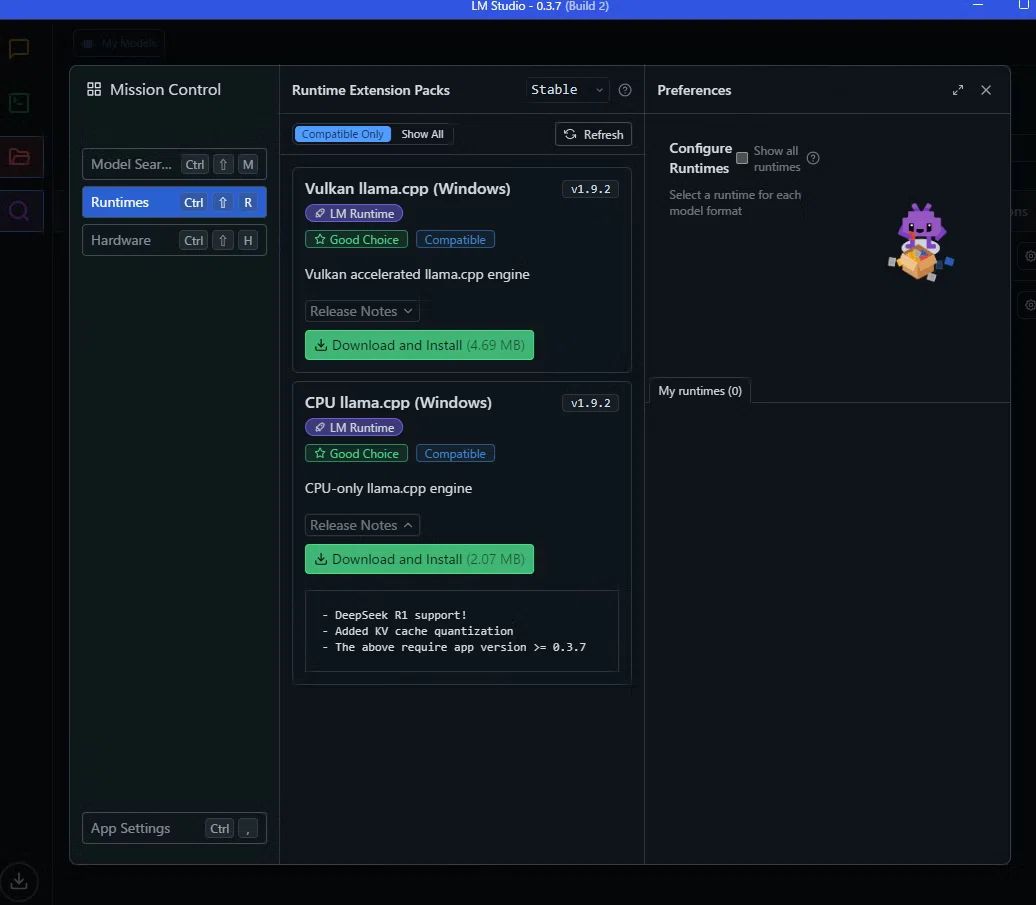

もしも以下のようなエラーが起きたら

RuntimesってとこからCPU llama.cpp (Windows)をインストールしましょう

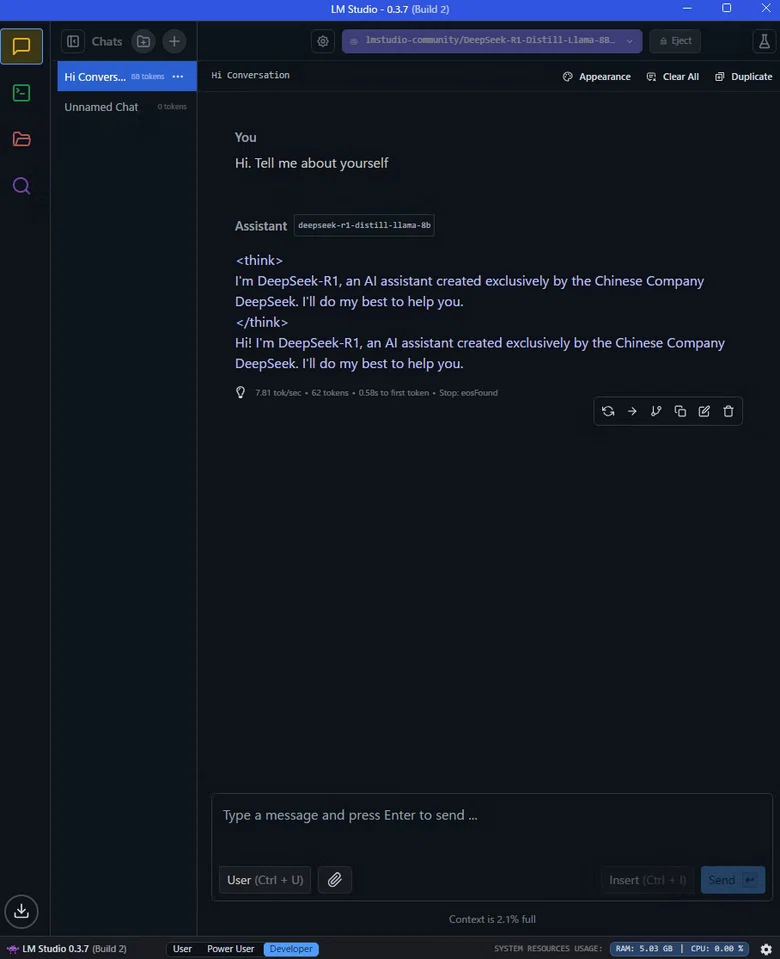

いざ会話開始

Chatメニューに行って

モデルを選んで新しいChatを始めましょう

できました

ネットなしでも動くとちょっと感動ですね.

Discussion