🐷

OllamaでLLM(Llama 3等)をローカルMacで動かす with WebUI

概要

- Ollamaを用いて、ローカルのMacでLLMを動かす環境を作る

- Open WebUIを用いての実行も行う

環境

- MacBook Pro 2023

- Apple M2 Pro

- メモリ 16GB

手順

Ollamaアプリのダウンロード

- 解凍するとダウンロードフォルダに入るので、アプリケーションに移動しておく

- この時点ではまだollamaコマンドは使えない

> ollama --version

zsh: command not found: ollama

コマンドのインストール

-

アプリを立ち上げて、「Install」ボタンを押す

-

Docker Desktopが動いている状態であれば、特に何かする必要はなく、GUIに従ってインストールすれえばDocker環境のGPU Accelerationを生かした状態で起動できる模様

Ollama handles running the model with GPU acceleration. It provides both a simple CLI as well as a REST API for interacting with your applications.

To get started, simply download and install Ollama.

We recommend running Ollama alongside Docker Desktop for macOS in order for Ollama to enable GPU acceleration for models.

- コマンドが使えるようになる

> ollama --version

ollama version is 0.1.32

モデルを動かしてみる

- 初回のみダウンロードで5分くらいかかる

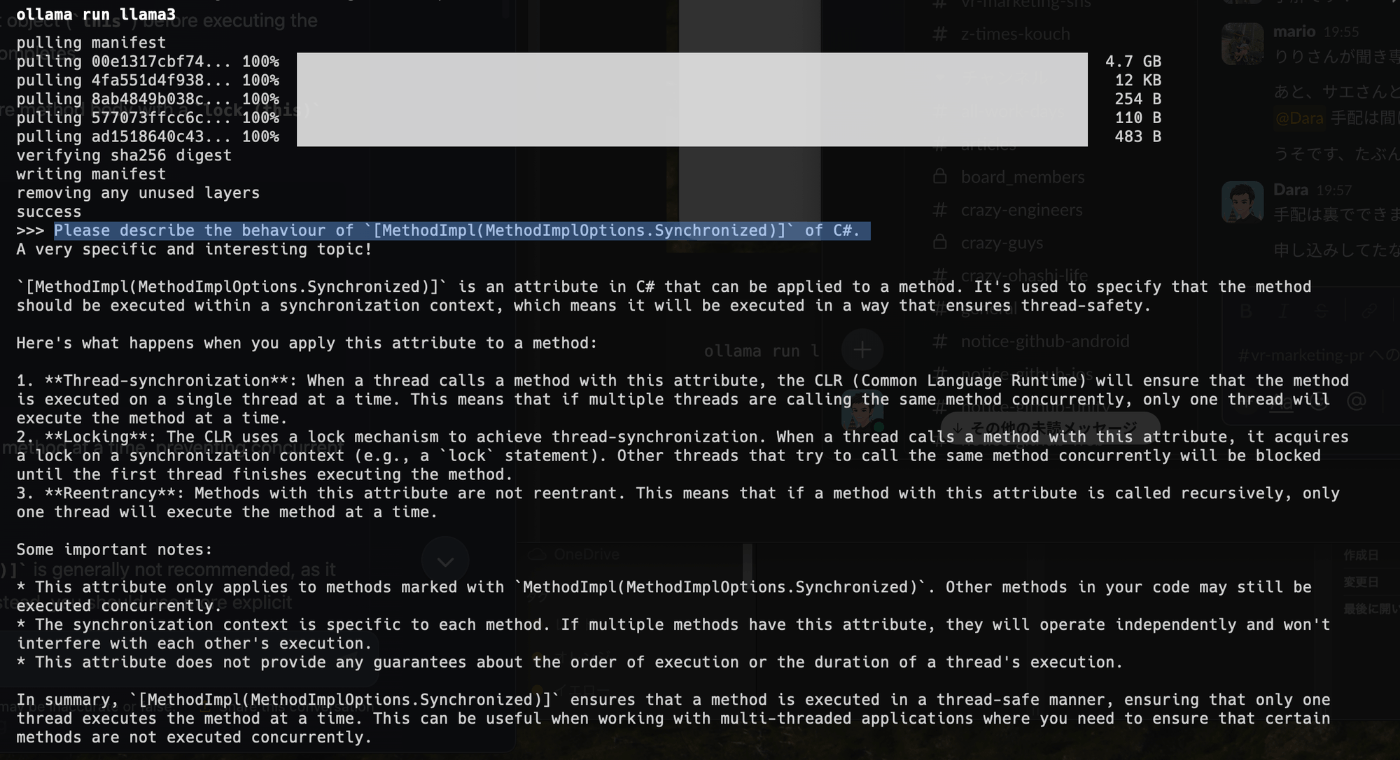

> ollama run llama3

- プロンプト(選択部分)を打ってみた。

- 終了する

>>> /bye

Web UIで動かす

- Open WebUI(元Ollama WebUI)を用いる

- "If Ollama is on your computer, use this command:"の方に従う

> docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

Unable to find image 'ghcr.io/open-webui/open-webui:main' locally

main: Pulling from open-webui/open-webui

22d97f6a5d13: Pull complete

b41a1d042542: Pull complete

be7f45f8a37f: Pull complete

bcb33e6fe64e: Pull complete

2dbc98364c88: Pull complete

53fd82458846: Pull complete

fbdf3f83c063: Pull complete

b40d6e00c708: Pull complete

54d67a42ae0e: Pull complete

2a95932c8382: Pull complete

002cefce91a8: Pull complete

93eed41d86d3: Pull complete

b395de805fe0: Pull complete

Digest: sha256:c75e215751eb741878f34fd841d910a018eb1bf2d17a9ffe731f24ab2bf3cca2

Status: Downloaded newer image for ghcr.io/open-webui/open-webui:main

350d732f7f1dfec5d9d62481966efcb2542e4223f5da7edb1264b380e17dc6a1

- dockerのプロセスが起動している

docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

350d732f7f1d ghcr.io/open-webui/open-webui:main "bash start.sh" 9 seconds ago Up 6 seconds 0.0.0.0:3000->8080/tcp open-webui

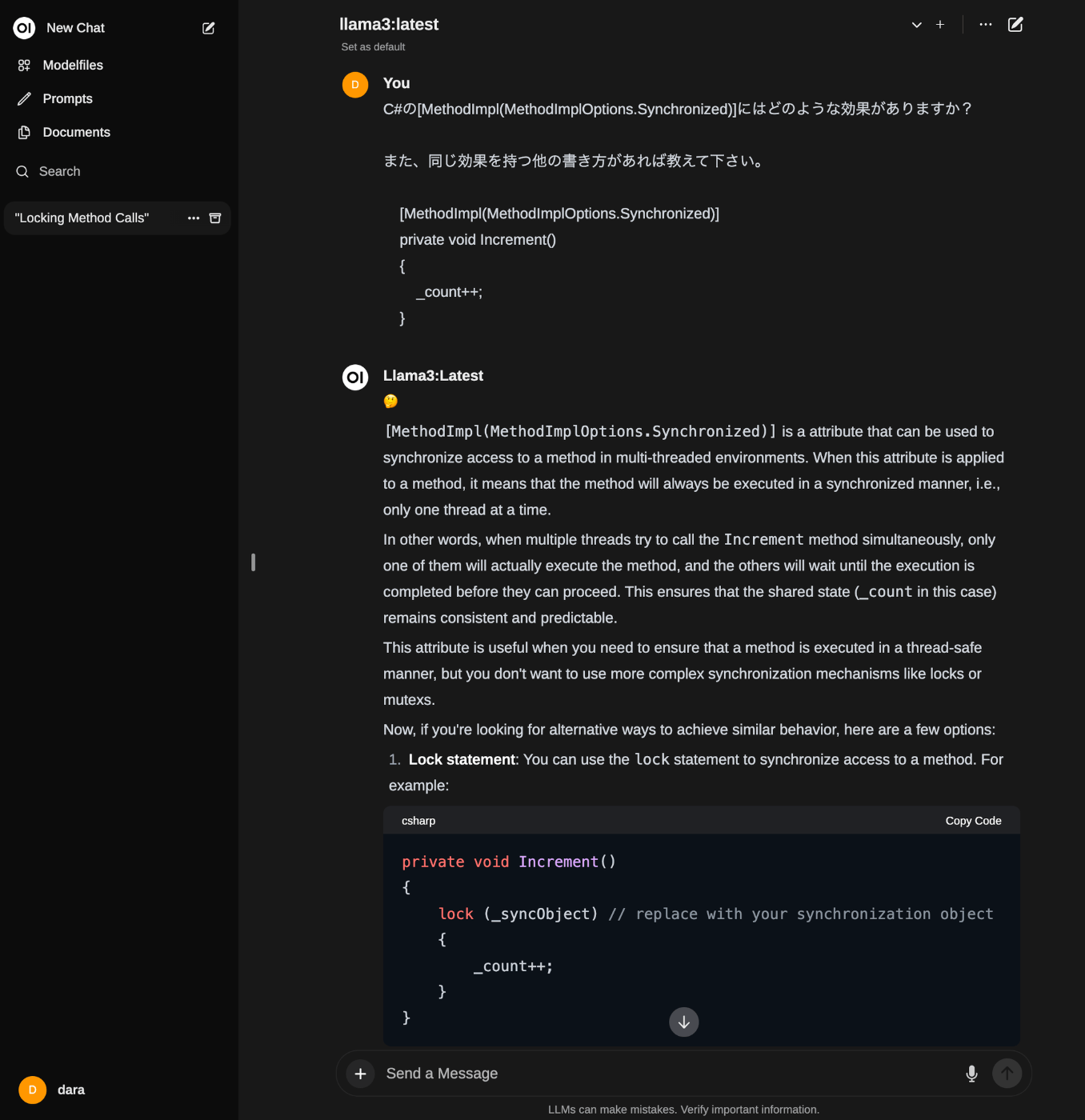

- ブラウザにアクセスすると立ち上がっている。(ChatGPTとほぼ同じUI)

http://localhost:3000/

Discussion