🦋

Mac StudioでローカルLLM(LM Studio)を使ってみた。

はじめに

勤務校(中学・高等学校)でMac Studioを購入し,ローカルLLMを試してみることにしました。

Mac Studio

Mac Studioのスペックは以下の通りです。

- Apple M2 Ultraチップ

- メモリ 128GB

- ストレージ 1TB

- OS macOS Sonoma v14.5

LM Studio

ダウンロード

まずは,LM Studioのホームページからアプリをダウンロード

- 2024/9/16 現在で LM Studioのバージョンは

0.3.2でした。

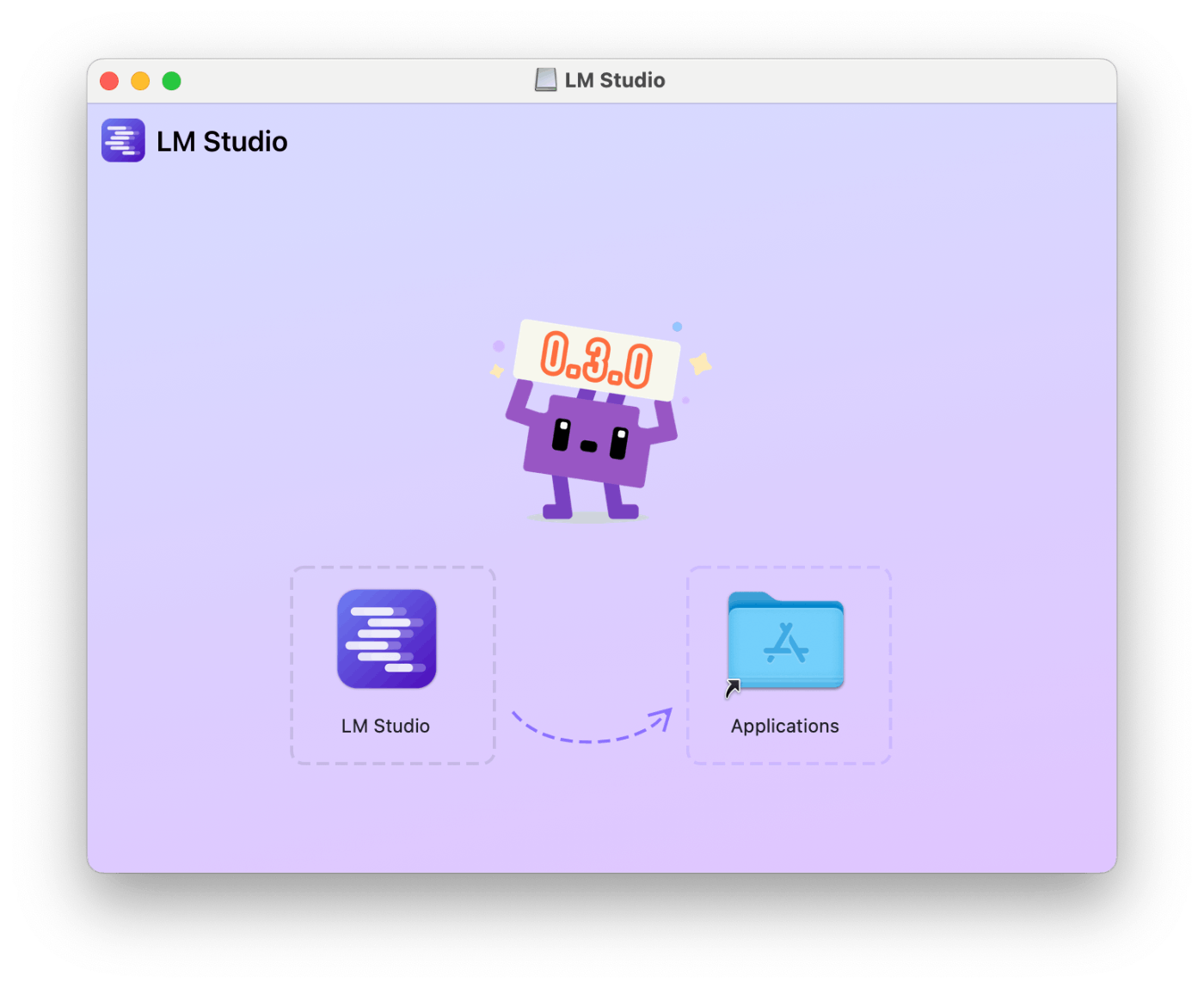

インストール

LM-Studio-0.3.2-arm64.dmgのダウンロードファイルをダブルクリックして,アプリケーションフォルダにアプリを入れて完了。Macのいつもの感じです。アプリを立ち上げてみると,以前のバージョンに比べて外観が変わっていました。

モデルのダウンロード

まずアプリを立ち上げたあとに,次はモデルのダウンロードです。どのモデルがいいのか余りよくわからなかったので新しいそうなものからダウンロードしました。

InternLM 2.5 20B

LLaVA v1.5

Meta Llama 3.1 8B

そのモデルが利用できるかどうかは右側のChoose a download optionのところでFull GPU Offload Possibleと表示されます。

ちなみに,利用できない場合(スペックが足りない場合)はlikely too large for this machineなどと表示されます。(下の画像はMacBookProでLM Studio を起動したスクショ)

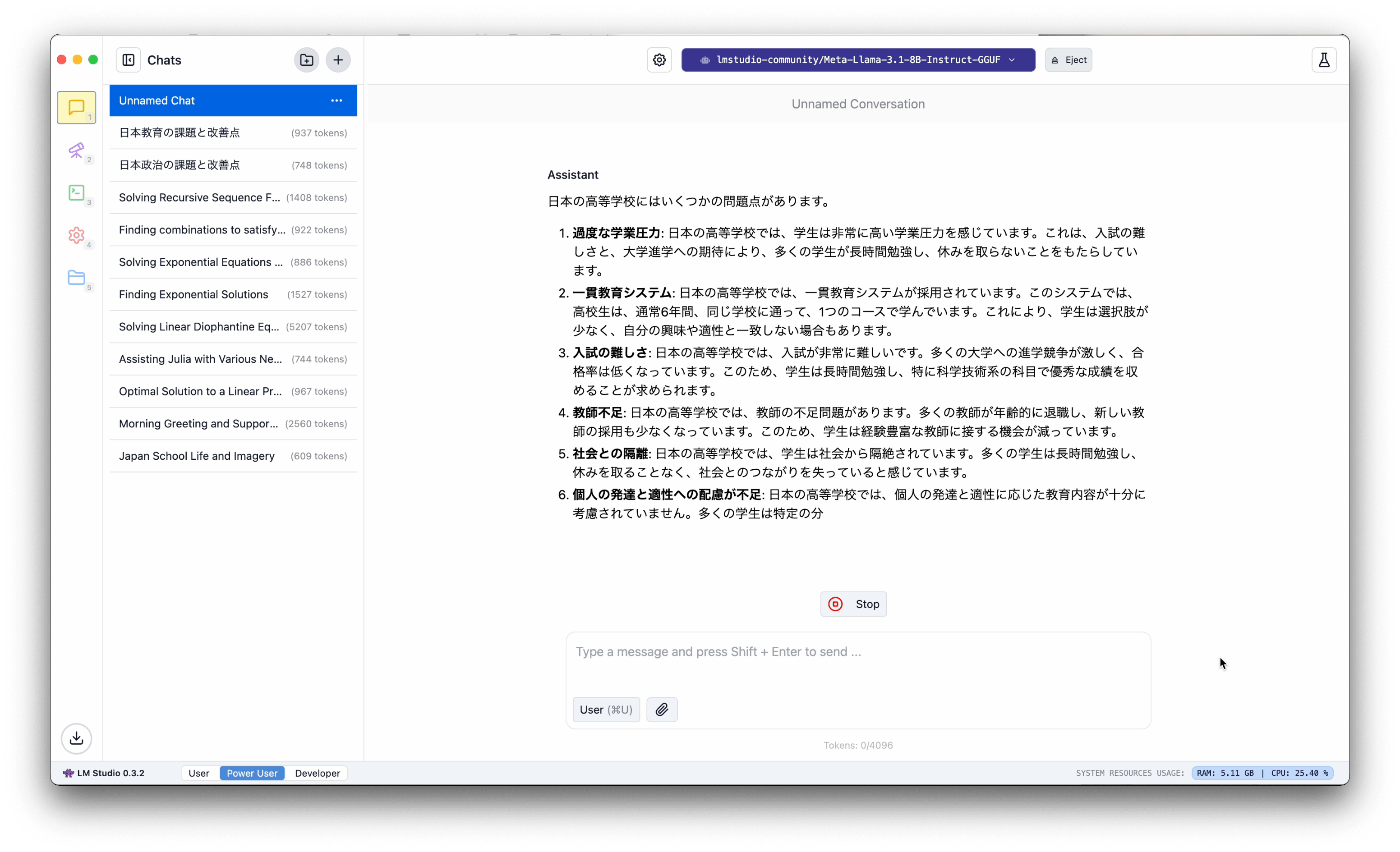

モデルを実行

あとはチャット画面からモデルを選択して,チャットを実行します。レンスポンスは早いですね。

Discussion