【SWTTokyo25レポ】UserCommunityHub : FrostyFriday〜生FrostyFridayやったよ!

がく@ちゅらデータエンジニアです。

こんにちわっ!

※ちょっと昔の状態のZenn記事を上書きしてしまって、後半消えてますorz

dbt Meetup #16 : dbt Tokyo crew就任&トリスタンCEO&東條Anthropic新社長にあう

→ Snowflake World Tour Tokyo 2025 Day 1 生FrostyFridayやったった

→ Snowflake World Tour Tokyo 2025 Day 2

→ (土曜日)1日中くたばってた

→ (日曜日)ほぼくたばってた

→ (祝日)子どもの体調があやしくて、外出せず。レポブログを結構書いた

ってことで、あまりに浦島状態で、仕事のエンジンが全然掛かりませんね!

※ってこれを書きはじめたのが火曜日だったんですが、何かしらんうちにタイムリープしてますね・・・>もう木曜日

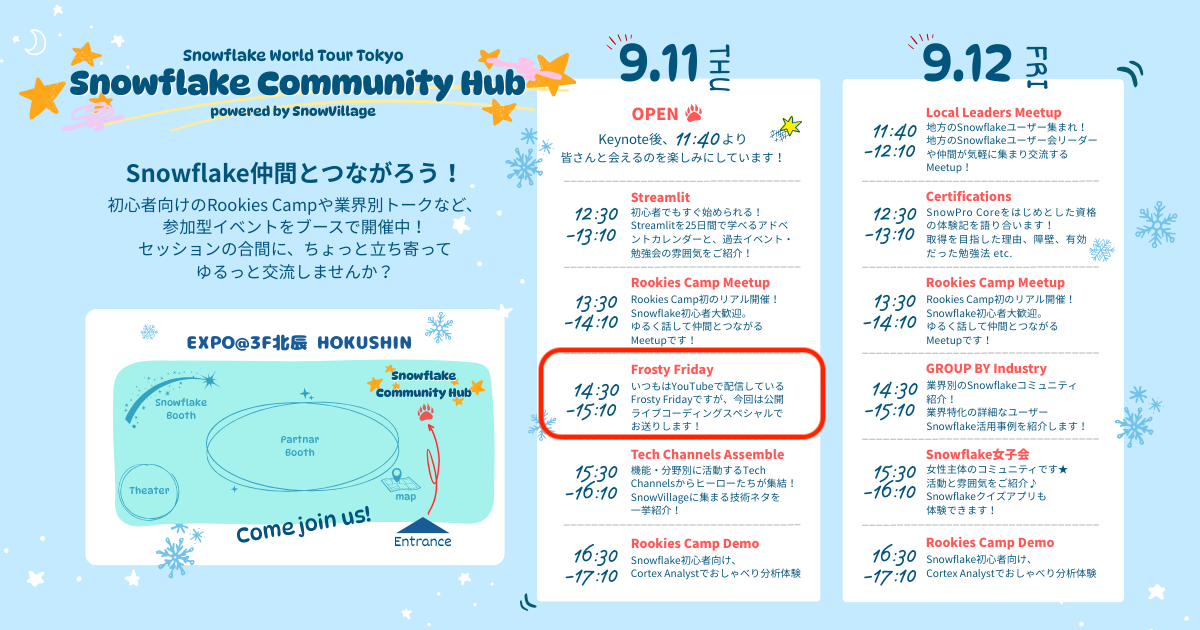

承前:SWTTokyo25のコミュニティブースでFrostyFridayの時間をもらえた

7月某日、SnowVillageのSlack:チャンネル「swt-2025-community-booth」にて、

Snowvillageのユーザ活動でブースで発表しませんか? ってお話がありました。

その中でFrosty Fridayでも1枠いただけることになりました

ちなみに、40分!!!!

最初はもっと短い時間で、

これまでの出演者などを繋いで、Frosty Fridayの紹介動画を繰り返し流すか〜

みたいな話をしていたのです。

けど40分ってことで・・・

「もしかして、これ生FrostyFridayできるんじゃね?」

※自分で自分の首を絞めたやつ

当日

EXPO会場にSNOWFLAKE COMMUNITY HUBの様子

事前告知もそれほどなく、コミュニティーブースでゲリラライブをやるような

ブースジャック状態!

生FrostyFridayLiveChallange!

まずこんな感じでスタート

内容としては

- MCの紹介

- Frosty Fridayって知ってますか?

- Frosty Friday Live Challangeとは

- 今日は生FrostyFridayやります!

という形で進めました。

MC自己紹介

サイレント・ウィッチまじ最高、作者さんまじ天才

ここで会場的な問題が・・・・

ブース前でやっているので、マイクがないんです・・・マイクが!

私は大声を張り上げてお話をさせていただいたのですが、

あれさん、tomoさんが地声で話すのはかなーーり厳しい・・・

※あれさんは、個人で小さなスピーカーを持ってきてくださってましたが、それでもなかなかきつい

結局、今回はほぼ私が一人でやらせていただきましたm(__)m

Frosty Fridayとは

こちらで隔週出題されていますね!

2025年9月時点で148問作成されています、ほんとすごい!継続すごい!!

Frosty Friday Live Challangeとは

こちらは、隔週木曜日22時からYoutube Liveで配信している

What's New + Topics & Frosty Friday 2Week分 をやってます

こちら最新で34回の配信をしてます

※ウォ、こんなにやってたんかぁ、すげぇぇ(自画自賛)

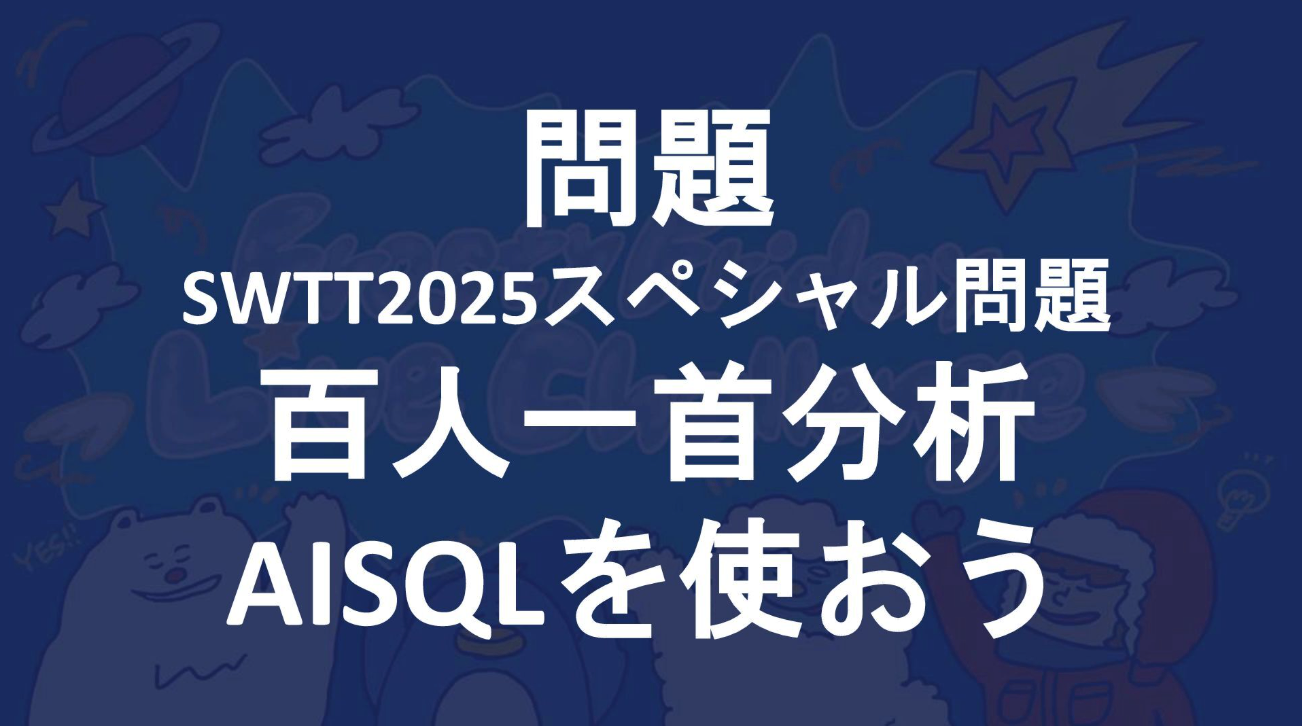

生FrostyFriday

今回は

Frosty Fridayから、Week1 Basic - External Stages

と

SWTT特別問題として、百人一首分析(AISQLを使おう!)

の2題をやりました。

百人一首分析は、私が作ったんだぜぇ!いえーい!

Week1 Basic - External Stages

解法は2つ

- 解法① 基本的な解法

- 解法② INFER_SCHEMA を使った解法

まずは、提供されているS3バケットをStageに取り込みます

SWTTokyo25特別問題 百人一首分析:AISQLを使おう

こんな問題を作りました

小倉百人一首のデータは、こちらからCSVを頂きました、ほんとにありがとうございます!!

Discussion