Closed3

What are Diffusion Models?

What are Diffusion Models?

Text: What are Diffusion Models?

一言で

拡散モデル(DDPM, DDIM)について解説した記事。

DDPMとは

生成モデルの一種で、入力データにノイズを繰り返し付加する過程(順方向の伝搬)と、ノイズから元のデータを復元する過程(逆方向の伝搬)からなる。データの生成時は、ある分布(通常Gaussian)からサンプルしたノイズを元に、逆方向の過程を繰り返し適用することで生成する。

- 順方向の伝搬: 入力データのエネルギーを減衰させながら、ある割合のノイズを付加する過程を繰り返し適用する(典型的にはN=1000)。最終的にガウスノイズと見做せるまで繰り返す。

- 逆方向の伝搬: NNによって付加されたノイズを予測し、キャンセルすることで信号を復元する過程。順方向の伝搬を逆に辿る。

NNのアーキテクチャはUnetベース。NNのパラメータは、NNが予測したノイズとベイズの定理によって計算されるノイズの理論的な推定値のMSE誤差が最小となるように誤差逆伝播法によって学習する。

Unetを繰り返し(典型的には1000回)伝搬させるので、生成速度は他の手法と比較するととても遅い。

研究分野における位置付け

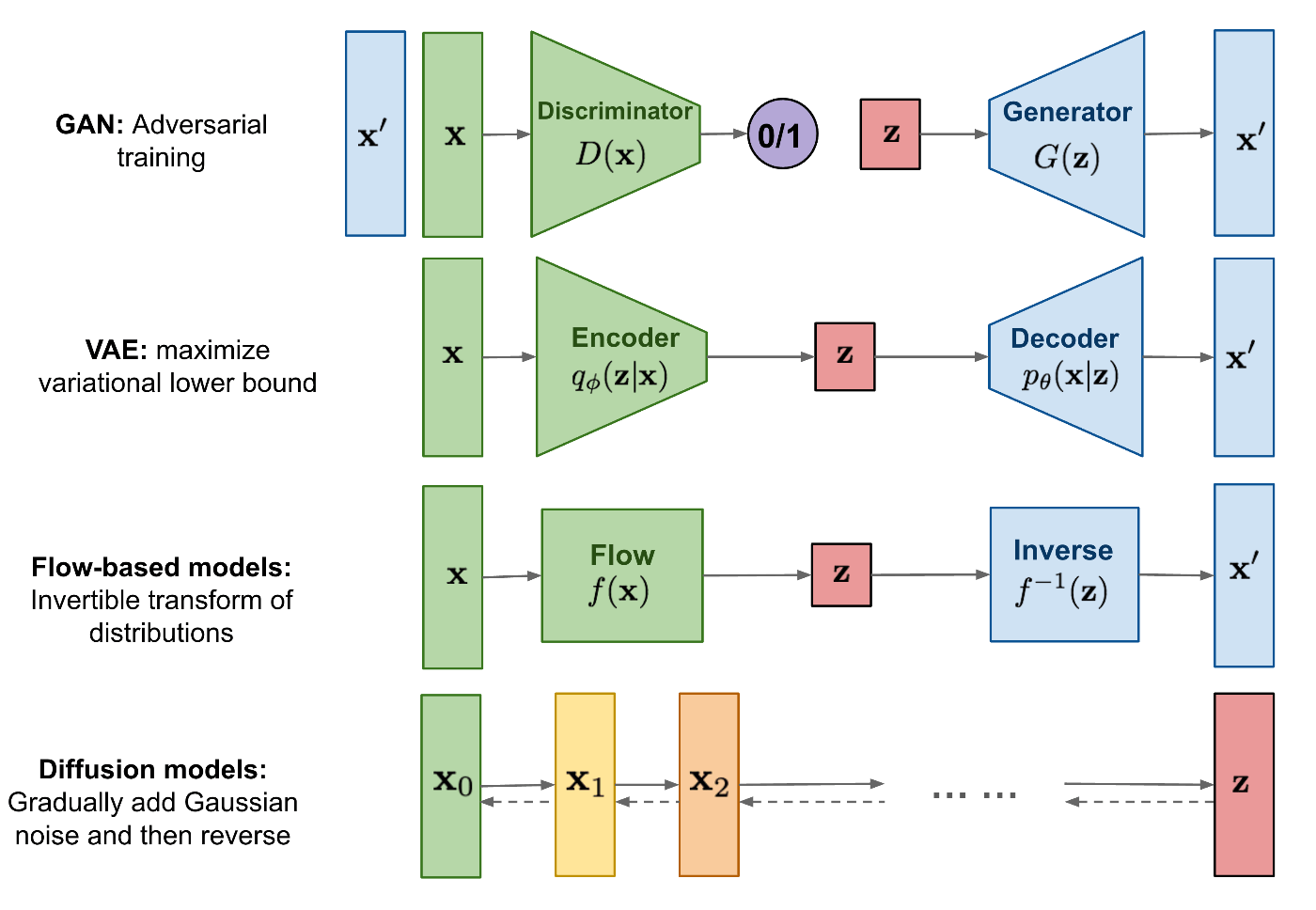

- GAN: 安定した学習が難しい。生成されるデータの多様性が限定的。潜在変数と生成されたデータは明示的な関わりを持たない。

- VAE: 代理損失(negative ELBO loss)による最適化。

- Flow-based models: 変換を可逆にするためにアーキテクチャに強い制約を課す

- 拡散モデル: 伝搬する情報は入力データと同じ次元をもつ。生成されるデータの精度は高いが、生成速度がとても遅い(GANの数千倍遅い。生成を高速化するテクニックを使っても数十倍〜数百倍程度)

Fig. 1 各生成モデルのアーキテクチャの比較。source

メモ

Forward diffusion process

Connection with stocastic gradient Langevin dynamics

- 勾配

\nabla_\mathbf{x}\log p(\mathbf{x})

\mathbf{x}_t=\mathbf{x}_{t-1}+\frac{\mathbf{\epsilon}}{2}\nabla_\mathbf{x}\log p(\mathbf{x}_{t-1}) + \sqrt{\mathbf{\epsilon}}\mathbf{z}_t, \text{where } \mathbf{z}_t \sim \mathcal{N}(\mathbf{0}, \mathbf{I})

所感

- 結局stochastic gradient Langevin dynamicsとどう関連しているのかがよく分からなかった。

Reverse diffusion process

-

L_\mathrm{VLB} \mathbf{x}_{t-1} \mathbf{x}_{0} \mathbf{x}_{t-1} \mathbf{x}_{0}

Parametrization of L_t

- Q. 生成過程におけるノイズ項

\mathbf{z}_\theta(\mathbf{x}_t, t) \sigma_t\mathbf{z} -

\mathbf{z}_\theta(\mathbf{x}_t, t) -

\sigma_t\mathbf{z} \sigma_t \sigma_t=\beta_t \sigma_t=\tilde{\beta_t} \sigma_t=\eta \tilde{\beta_t} -

\beta_t -

\tilde{\beta_t}

-

-

所感

- 生成時のノイズ

\sigma_t \sigma_t=0

このスクラップは2022/08/14にクローズされました