Open1

Phi-4: 14Bと小規模ながらGPT-4oレベルの性能のモデル

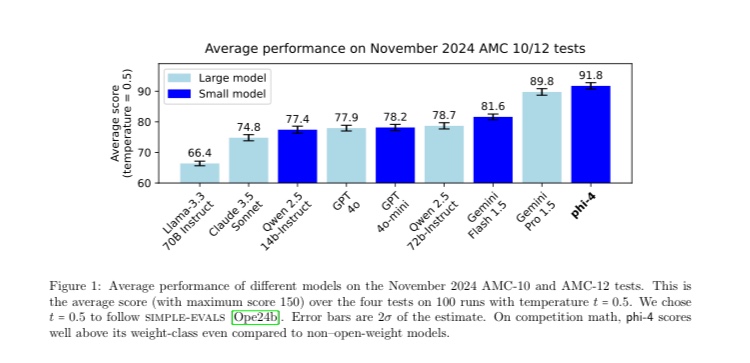

MicrosoftがPhi-4というのを出してきて、14Bと比較的小規模ながらQwen2.5 72Bはおろか、Gemini proなどの大規模モデルもを大きく引き離す性能を報告している。

彼らの技術文章によると、おもに性能に寄与してそうな工夫はデータのキュレーションとDPOのアルゴリズムのようで、Alibabaのo1-likeモデルMarco-o1とは異なる戦略をとっている。

彼らの手法はPivotal Token Searchと呼ばれるもので、DPOで正解へと導く可能性に最も寄与した(or 阻害した)トークン(基軸トークン)を起点としてPath searchを行う手法とみなすことができる。

正解へと導くトークンの出力確率を上げるような学習を行う、という意味ではMCTSとにているが、MCTSとは異なり学習時にやってしまう。つまり、推論時に追加でpath探索のコストが不要である。