Cline での手癖を Quick に矯正する

👉本ブログは AWS AI Agent ブログ祭り (Zenn: #awsaiagentblogfes, X: #AWS_AI_AGENT_ブログ祭り) の第 13 日目です。

はじめに

こんにちは、みなさんは Agentic AI を仕事に利用できていますか?

私は業務をどんどん AI におまかせしています。

使い始めの頃はどう使えばいいんだろうと、正直悩むことはありましたが、最近は息を吸うように「まず AI に投げる」というという手癖がついてきたように思います。

手癖が大きなトラブルを起こす訳では無いですが、 最新のモデルのお気持ちを察するともっと効率的に仕事ができるのに、私の古いプロンプトでキャップをかけているなら、それはもったいない と感じるわけです。

シンプルな指示でおまかせしたほうが成功確度が上がったり業務にかける時間も短くすむなら素晴らしいですよね。

今回はもっと効率的に業務ができないかを探るため、Cline の操作ログを Amazon Quick Suite に渡し、もっと効率的に開発するアドバイス を貰いましょう。

Quick Suite にはいくつかの機能があります、後日プロンプトを使いまわしたりすることも想定し、今回は Flows を利用します。

このブログでは Space で Cline のナレッジをためて、Flow から利用する流れにします。

1. Cline のベストプラクティスをダウンロードする

Cline のベストプラクティスとして公式のドキュメントを利用します。それぞれページを開き、右クリックしてローカルにダウンロードします。

Context Management

Prompt Engineering Guide

Cline Memory Bank

2. Cline の操作ログを取得する

Cline の操作ログを作業ディレクトリに保存します。

{{USER名}}, {{エディタ名}} と {{Clineのディレクトリ}} は皆さんの環境に読み替えてください。

私は Mac 環境でしたので、下記のようなコマンドですが、Linux や Windows だと違うかもしれません。(Linux, Windows だとこうだったぜなどあれば、コメント欄などでフォーラム的にワイワイ盛り上げてくださると、どなたかの参考になるかもしれません。)

find "/Users/{{USER名}}/Library/Application Support/{{エディタ名}}/User/globalStorage/{{Clineのディレクトリ}}/tasks" -name "ui_messages.json" -type f | sort -R | head -3 | while IFS= read -r f; do dir=$(basename "$(dirname "$f")"); cp "$f" "./${dir}.json.txt"; done

3. Amazon Quick Suite にサインアップする

Amazon Quick Suite のサインアップ画面へアクセスし、サインアップを進めます。

- アカウント名

- アカウント通知用メールアドレス

をそれぞれ入力し、アカウントを作成ボタンを押下します。

※ アカウント名は一意である必要があります、

しばらく待つとアカウント作成が完了します。

リージョンが us-east-1(バージニア)であることに注意してください。

また、此処から先の手順は日本語で進めていきます。

4. ナレッジを保存するための Spaces を作る

Spaces の新規作成ページ から新しい Spaces を作ります

先程ダウンロードした Cline のベストプラクティスをアップロードします。

5. Flows を構築する

では分析手順を Flows で組み上げます。

Flows のコンソールページ から「空白のフローを作成する」ボタンを押下し手動でフローを組み上げます。

初期のノードがいくつか用意されていますが、すべて削除し空白の状態にします。

そして、「ファイルアップロード」のノードを追加します。

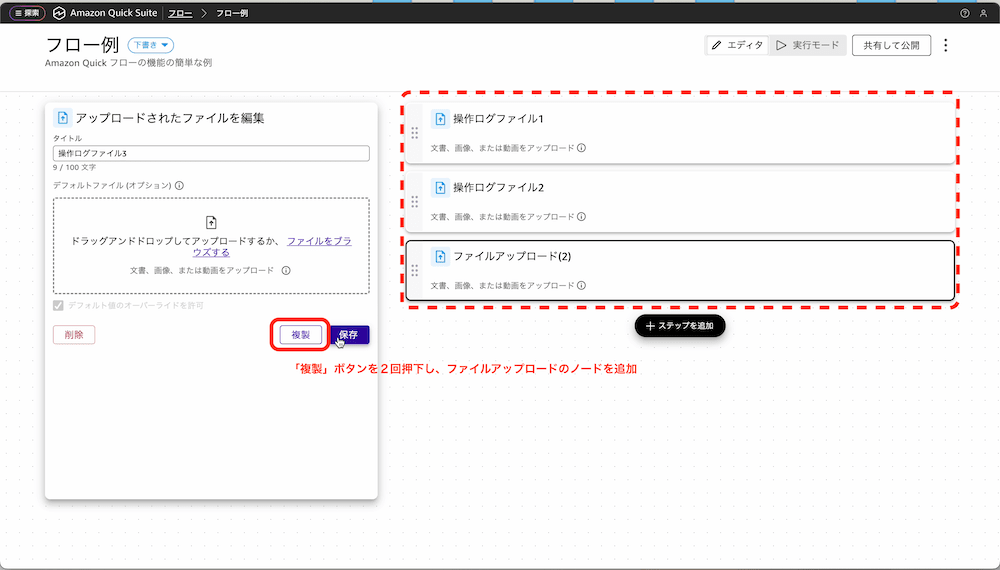

今回は3つのファイルをアップロードできるように複製します。

次に「一般知識」のノードを追加します。

そして、プロンプトを入力します。

下記のプロンプトを使います。

<data1>

操作ログファイル1

</data1>

<data2>

操作ログファイル2

</data2>

<data3>

操作ログファイル3

</data3>

<instruction>

quick suite data の space としてベストプラクティスへのアクセスが可能です。

ベストプラクティスに沿ってより効率的な開発をするためのアドバイスをしてください。

渡したjsonファイル群には私のclineの操作ログがあります。 わたしのclineの手癖を分析したいです。 やさしい日本語で500文字程度の文章を期待します。また箇条書きは行間が読めないので禁止します。

さらに、引用を含めて回答してほしいのですが、該当箇所の抜粋はなくても良いですし、10文字など可能な限り短くして読みやすさを重視してください。

clineの操作ログはjsonですのでこれを加味して私の手癖を分析してください。そのうえで、私がうまくできていることと、より作業効率を上げたり、成功確度を上げるための方法を教えて下さい。

</instruction>

さらに、「クイックスイートデータ」から先程作った Spaces を紐づけます。

Spaces の紐づけ画面は下記の通り操作します。

では、フローを組み上げられたら、実際に使ってみましょう。

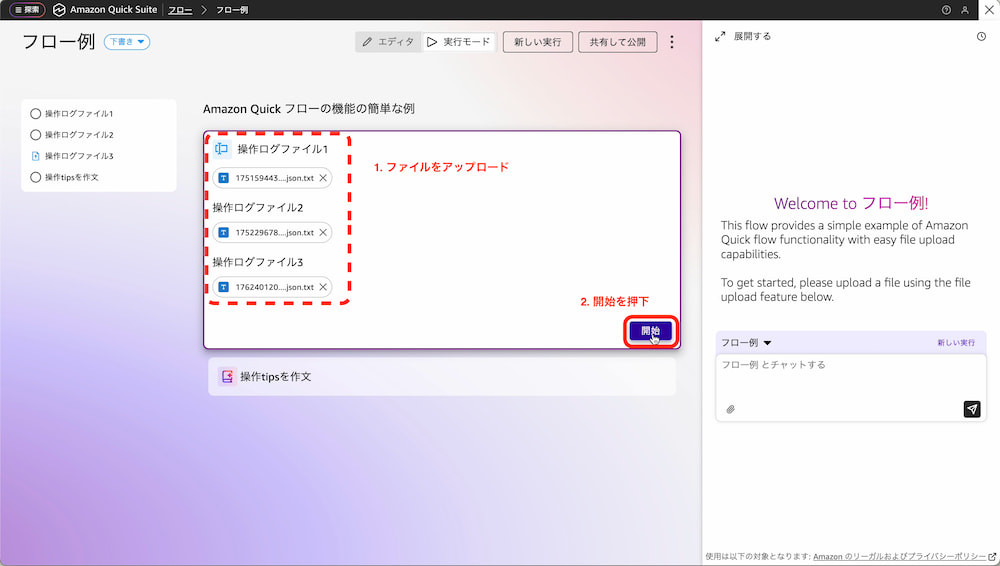

3 つの json ファイルをアップロードして、「開始」ボタンを押下します。

Memory Bank を活用すべきというアドバイスが貰えましたね。

まさに、後で使ってみようと思っていて、後回しになっていた機能でした。

今度触ってみようと思います。

Amazon Quick Suite の削除

Quick Suite の管理ページから Manage ボタンを押下し、削除を進めます。

まとめ

このブログでは Amazon Quick Suite を使って、Cline の操作ログを分析してみました。

ファイルもアップロードできて、Agentic AI つまり、動作の挙動を自ら考えて分析、実行してくれるマネージドサービスはすごく便利だなと感じました。

他のデータでも「人間が読むのが億劫になるようなデータ」を解釈するのを補助してもらうという観点で、汎用性が効きそうです。

ぜひみなさんも定型的な調査業務に Amazon Quick Suite を試してみてはいかがでしょうか。

Discussion