ONNXRuntime Unity Plugin

Sentis (旧Barracuda) を使わないOnnxネイティブプラグイン。こちらのリポジトリで開発中です↓

Unity BarracudaがSentisに変わって迷走しているなか、別の選択肢を試して置くことは大事だなと思い

OnnxRuntimeをUnityで動かす実験をしてみます。

Onnx自体がMicrosoft製ということもあり、C APIをC#から叩くコードは全部含まれていて、それとUnity側の世界を繋げてあげるあげるだけで動きそうな予感。うまく行けばWebでも同じコードで動くかもという淡い期待。

それとStable Diffusion系も豊富にONNXモデルに変換されていて、Onnx Runtimeでも動くといいなと。

pre processは HuggingFaceのDiffusersリポジトリが参考になりそう。

Onnx RuntimeはMicrosoft製というだけあり、C#のAPIが整備されていてクオリティも高いので、変な自作はせずにそのまま使いたい。その時に厄介になるのはのは、DllImportで定義されている#define

PlayerSettingsの Scripting Define Symbolsに入れれば動くと思わわれるかも知れないが、EditorでもAndroidやiOSが有効になるので、Editor実行時にも動作させるには、TensorFlow Liteで定義したようなUnity Editorを除外する処理を書かなくてはいけません。Onnx Runtime本家で対応してくれないかな…。

本家にPR送ってみるのもありだけど、ひとまずUnityで実行出来るように、ビルド前に無理やりPlayerSettings.SetScriptingDefineSymbolsでdefineを書き換えるということをしてみた。一応動いている気はする。

テストで入れた、軽量なImage classification model Apple MobileOne がmacOS, iOS, Androidで動いたので、とりあえず、Unity package方式でプレビューリリース。

他のプラットフォーム対応。GPU acceleration 対応。 などなどやることはまだまだ沢山あるが、ひとまず、Unity BarracudaやSentisで動かないようなOnnxモデルもUnityで動くなるのは喜ばしい限り。

UnityのWebカメラ入力をリサイズしてNCHW変換するところもCompute shader一発で行けたので、TensorFlow Liteでの知見が生きている。

Tokanizer等の面倒くさいpre/post processingも extensions という形でネイティブ実装されているみたい。便利!

Yoloxも動いた。macOS/iOS上のCoreMLは動くけど、AndroidのNNAPIではCPUにフォールバックされて遅い。でもCPUモードも十分速いですね。

次はextensions対応。

解説記事書いた。

WindowsとLinux対応を追加中。

CPUのライブラリのサイズは小さいのだが、CUDAのGPU providerがそれぞれ300MB以上あり、全部を

GitHub LFSで管理するのも辛いなーと。

私のGitHub LFSの99%はTFLiteのためにお金払っている。こんなに使ってもらえると思わなかったので適当に全部入りにしてしまった…。

ということでお金の節約も考えて、最初からNPMだけにするかな。

はじめは全部をまとめてNPMにpublishしようとしたら、413 Content Too Largeで公開出来なかった。NPMの公式の最大ファイルサイズはちょっと見つからなかったけど。

選択肢として、NuGetへ移行することも調べたが、NuGetも最大ファイルサイズは250MBらしい。NuGetでも機械学習ライブラリを公開したいのに最大サイズが小さすぎと議論されていた。わかる。

なので、NPMのまま、WindowsとLinuxのGPU providerはCore packageから分割することにした。

Windows DirectX12で動くDirectML版はonnxruntime.dllに統合されていて、バイナリサイズも1MBくらいしか変わらないので、コアパッケージに入れてあげるのがいいかも知れないな。

UnityユーザーのWindowsにCUDAは入ってない可能性高いので。

XNNPACK対応入れてみた。けど、テストに使ってるモデルがXNNPACK対応してないみたい?もっと単純なモデルで検証必要かな。

Add operatorだけの単純なモデルで単体テストを作った。

ONXX Runtime Extensions

この辺を参考にmacOS Fat dylibをビルドしてみた。

cmake -D CMAKE_OSX_ARCHITECTURES=x86_64 "$@" ../../.. && cmake --build . --config $BUILD_FLAVOR --parallel "${CPU_NUMBER}"

cmake -D CMAKE_OSX_ARCHITECTURES=arm64 "$@" ../../.. && cmake --build . --config $BUILD_FLAVOR --parallel "${CPU_NUMBER}"

でそれぞれビルドして最後に

lipo -create -output libortextensions.dylib path_to_x86_64//libortextensions.dylib path_to_arm64/libortextensions.dylib

で結合する。で合ってると思う、

違った。Cmakeは

CMAKE_OSX_ARCHITECTURES="arm64;x86_64"

を指定するだけで、Fat バイナリを生成できるようになっていた。

最終的に、macOS, Windows, LinuxをGitHub Actionsでビルド出来るようになった。

Stable Diffusion

Hugging FaceのOrtドキュメント

ONNX RuntimeのSDXLデモ

Onnx C#でのチュートリアル

複数のORTモデルの重ね合わせ技で結構難しそう。

チュートリアルのブログみてるけど、pythonの移植だけど、LINQの無駄多すぎだしちょっと別のものを検討するのがよいかも?

こっちのほうが良さげ?

Mediumにも解説書いた。

ONXX 2GB超のモデルファイルの扱い

ONNXのファイルフォーマットは、ProtoBufに依存している。それの制約で、2GB超のファイルを扱えない。

Stable Diffusionなどの大きいモデルでは、

- model.onnx

- weights.pb

とファイルが分かれることがあるみたい。

- model.onnx

- model.onnx.data

となってるやつもある。これらをORTフォーマットに変換することは出来るのかな?

.onnx拡張子を取り扱うと、OnnxRuntimeプロジェクトでUnity Sentisをインストール出来なくなるため、.onnxではなく、*.ortだけのサポートにしたかったが。

調査中。

Unity のPackage Managerからみるパッケージの見た目を整える作業。

公式ドキュメント

このリポジトリが参考になった。

このJetsonリポジトリが、いい感じにローカルで動きそうな、かつ面白い事例が集まっている。

マルチプラットフォームで動作

- Classification

- Object Detection

- Segmentation

という基本的なサンプルを追加。基本は完了した気がするので、閉じます。

OnnxRuntimeのバージョンを更新しようとしたらてっきり忘れていたので、再オープン。作業を残しておくほうが良さそう。

OnnxRuntime 1.19.2

Windowsのパッケージがzipからnupkgに変更されたくらいで問題なくアップデートできた。

OnnxRuntime Extensions 0.12.0

ビルド環境としてサポートされているORT versionが1.17.1までなのが不満だが、問題なくGitHub Actionsでのビルドもできた。

ORT-ExtensionsのAndroid用バイナリがダウンロードできていない事に気づいたので、それも修正した。

OnnxRuntime v1.20.0 対応

が出てたのでバージョンアップを試みたところ、ライブラリの更新は問題なく言ったのに、GitHub Actionでnpm publishが失敗するという現象。毎回、npm publish --dry-run が通るのを確認してから実行しているが、dry-runは通るのに、本番実行するとエラーという現象。

ログを確認すると、ファイルサイズが大きすぎるとのこと。

npm notice unpacked size: 674.5 MB

npm notice shasum: a68a74ffe9c4f600dedf7ce72da6b7d17b2a0a90

npm notice integrity: sha512-9xM4z3UwO+1Mv[...]m+IccHdYt5TIw==

npm notice total files: 15

npm notice

npm notice Publishing to https://registry.npmjs.org/ with tag latest and default access

npm error code E413

npm error 413 Payload Too Large - PUT https://registry.npmjs.org/com.github.asus4.onnxruntime.win-x64-gpu - Payload Too Large

npm error A complete log of this run can be found in: /home/runner/.npm/_logs/2024-11-21T13_20_26_678Z-debug-0.log

Error: Process completed with exit code 1.

npm公式でのファイルサイズ制限は確認できなかったのものの、Azure-devopsや、以前までうまく言っていたバージョンのファイルサイズを確認するに、npmには、単体ファイル500MBという制限があるみたい。 OnnxRuntime v1.20.0のリリースノートにCUDAパッケージに新しいdependenciesが追加とあるので、それでパッケージサイズが増えてしまったみたい。仕方ないのでCUDAのライブラリはnpmに公開することを諦めるしかないか…。とはいえ自分でOpenUPMの仕組みだと(幸運にももし人気がでてしまったときに)自分のGitHub LFSの通信料がかかるので、無料公開のライブラリとしてはなかなかつらい。

ひとまずGitHub Releaseにzipでおいて、手動ダウンロードしてもらう仕組みに帰るかな…。

Onnx Runtime v1.20.1 対応

DirectML prebuiltライブラリがGitHubリリースから消えてる…。自前ビルドはメンテしたくないので、

こっちからダウンロードするようにすればいいかな。

NuGetの方に全プラットフォームのライブラリが色々まとめて入っているのに気づいた。悩ましい。

自分でトレーニングしたYoloxモデルが動かないって連絡もらって調べたら、入力画像が

このリポジトリで使ってたモデルでは、[0.485, 0.456, 0.406] [0.229, 0.224, 0.225]のNormalization必要なのに対して、オリジナル版では 0 ~ 255 のbyteを入力するだけだった。

オリジナル版で カスタムモデル作ると動かないってなるらしいので、オリジナル版に合わせた。

YOLOv11 Segmentation

Ultralyticsは、AGPLライセンスなので組み込む気はなかったが、見てみるとモデルのexportに力を入れていて、書き出し時にNMS有り無しを選べたりと、便利そう。選択肢として一度試してみてもいいかも。

ポストプロセスはこれを実装すればいいぽいけど、やってることわからんな。

output0 detectionの方はパースできた。

shape: 1,116,8400 (Batch_size=1, xywh+conf_cls(80)+nm(32), Num_anchors)

なんだけど、8400, 116で出力してくれればメモリ配列的に扱いやすいのだが…。

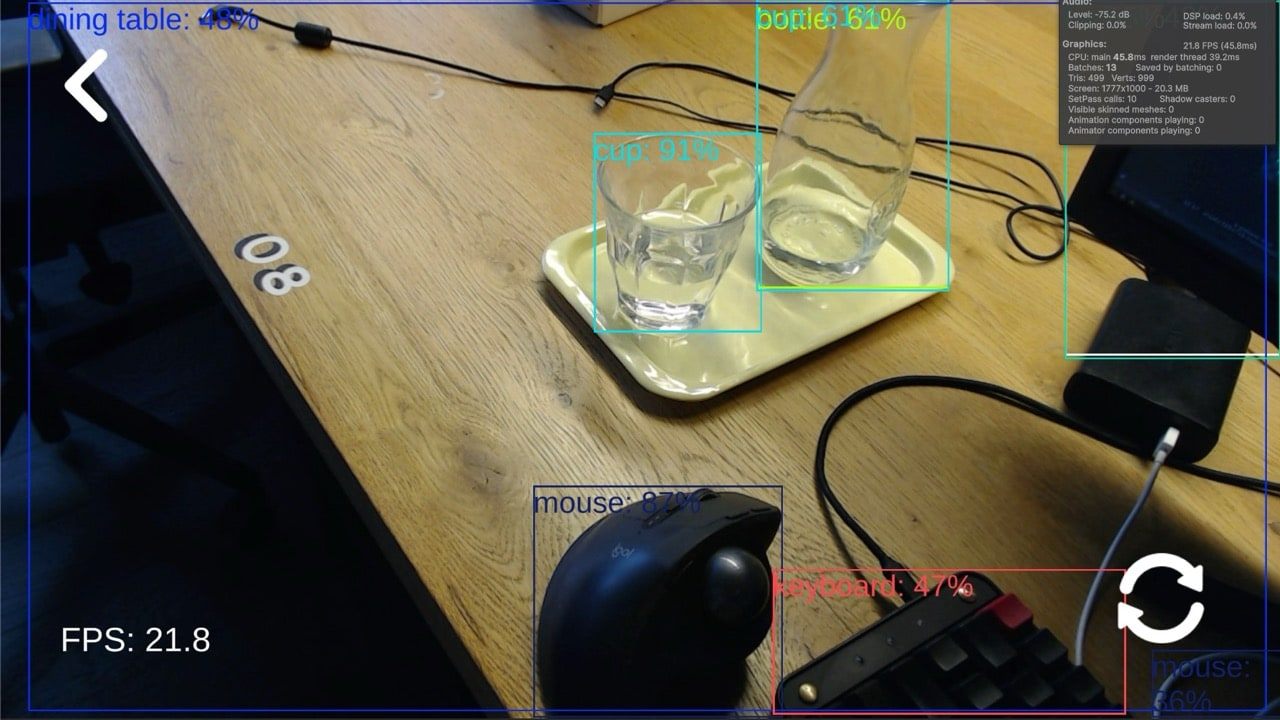

机をみるにMulti-class NMSもちゃんとできてるぽい

一番重いのはOnnxだが、ポストプロセスもmac Editorで4msかかっている。モバイルだともっと遅くなるの。

shape: 1,116,8400 (Batch_size=1, xywh+conf_cls(80)+nm(32), Num_anchors)

メモリレイアウト的に、8400を縦に重い気がするのでtransposeを試すか。

大体できた!

PostProcess を1.2msくらいまでは最適化できた。

Support Dynamic Shape

Netronでみるとこうなっているやつ。

Dimensionsの値はマイナスになっている。

Input:

[images] shape: -1,3,-1,-1

Output:

[output0] shape: -1,116,-1

[output1] shape: -1,32,-1,-1

16:9よりも長いアスペクト比のデバイスが多くなっている中、正方形のモデルをロードするのは非効率なので、Dynamic shape対応もしたい。

Dynamic Shape対応できた!結構APIの変更でたので、バージョン0.2 から 0.3へ。

けどCoreMLのGPU上で思ったより早くならなかったので、縦横アスペクト比の固定モデルを2種類用意するほうが現実的なのかもしれないな。

Base line RT-DETRv2-S のモデルをCoreMLつきで動かしてみたけど、思ったより遅いな…。これは TensorRT最適化モデルかな?

NMS Non-Maximum-Suppression

NMS処理を共通化するクラスつくった。地味に便利なのでTFLite側にも入れたい。

UnityEngine.Rect はよくよくMLモデルから出力されるRectとY軸が反転しているのでややこしい。CenterRect みたいな別クラスを作った方が混乱が少ないかもしれない。

ONNX Runtime GenAI の実験は長くなりそうだったので別のスクラップへ↓