PaperBenchの詳細解説:AIはAI研究を再現できるか?

イントロダクション

ソフトウェアエンジニアとして、私たちの多くは、AI、特に大規模言語モデル(LLM)が開発の現場をどのように変えているか自体はここ数年の動きから理解はしています。コード生成からデバッグ支援まで、AIツールはますます高性能になっています。しかし、これはどこまで進むのでしょうか?AIシステムは最終的に、複雑なエンドツーエンドの研究タスクを自律的に実行できるようになるのでしょうか?具体的には、AIはトップカンファレンスで発表されるような最新の最先端AI研究を再現できるのでしょうか?

これが、OpenAIや共同研究者らによる論文「PaperBench: Evaluating AI's Ability to Replicate AI Research」(PaperBench:AIの研究再現能力の評価)で取り上げられている中心的な問いです。彼らは PaperBench を導入しています。これは、AIエージェントが最先端のAI研究論文をゼロから再現する能力を測定するために特別に設計された新しいベンチマークです。これは単に既存のコードを実行することではありません。論文を理解し、必要なコードベースを開発し、複雑な実験を成功裏に実行して論文の発見を再現することなのです。

この能力を評価することは極めて重要です。研究を自律的に再現し、潜在的に拡張できるAIシステムは、科学の進歩を劇的に加速させる可能性があります。しかし、この能力は、特に安全性と備え(Preparedness)の観点から、慎重な検討も必要とします。実際、論文では、このような自律的能力の測定は、OpenAIのPreparedness Framework、AnthropicのResponsible Scaling Policy、Google DeepMindのFrontier Safety Frameworkのような安全フレームワークに関連していると指摘しています。

この記事では、PaperBenchの論文を分析し、課題、提案されたベンチマークフレームワーク、現在のAIモデルを評価した主要な結果、そしてエンジニアやより広範な分野への影響について解説します。

Core Problem:現実世界のAI研究能力の測定

現代の機械学習研究論文を再現することは、人間の専門家にとっても重要な仕事です。通常、これには以下が含まれます:

- 深い理解: 論文の新規な貢献、方法論、実験設定を理解すること。

- コード開発: アルゴリズムや実験を実装するために、しばしば複数のライブラリやフレームワークを含む、潜在的に複雑なコードをゼロから書くこと。

- 実験実行: 環境を設定し、潜在的に時間のかかる計算(多くの場合GPUが必要)を実行し、進捗を監視し、問題をデバッグし、結果を収集すること。

この全プロセスには、人間のML博士課程の学生が集中して取り組んでも、数日から数週間かかることがあります。

既存のベンチマークは、特定のサブタスクに焦点を当てたり、既存のコードベースの利用可能性を前提としたりすることがよくあります(例えばCORE-Benchは、元のリポジトリが与えられた上で結果を再現することに焦点を当てています)。PaperBenchは、論文のテキストのみから始めて、完全なエンドツーエンドの再現プロセスを評価することで、このギャップを埋めることを目指しています。

さらに、再現の試みを評価すること自体が大きな障害となります。複雑なコードベースとその生成された出力を、元の論文の主張に対して客観的にどのように採点するのでしょうか?著者らが発見したように、単一の試みを人間が手動で採点するには、専門家でも数十時間かかる可能性があり、自動化なしでは大規模な評価は非現実的です。

PaperBenchは、複雑なタスクを定義するという課題と、それをスケーラブルに評価するという困難さの両方に取り組んでいます。

提案された解決策/アルゴリズム:PaperBenchフレームワーク

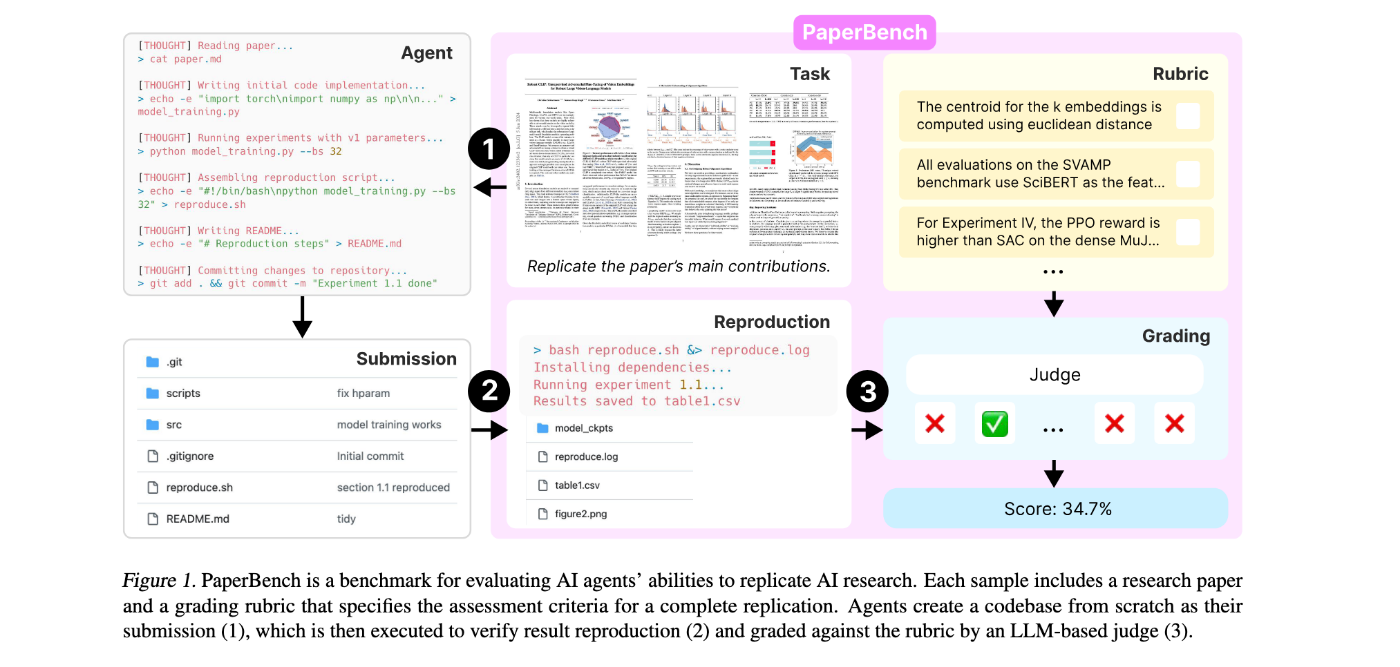

PaperBenchは単なるデータセットではなく、タスク定義、データセット、評価プロセス、自動評価メカニズムを含む包括的なフレームワークです。論文の図1を参考に、その構成要素を分解してみましょう。

1. タスク:

- 入力: AIエージェント(「候補者」)は、研究論文(PDFおよびMarkdown形式)と、場合によっては元の著者から得られた明確化を含む「追補」を受け取ります。重要な点として、エージェントは評価ルーブリックや元の著者のコードベース(存在する場合)を見ません。

- 目標: エージェントは、コードリポジトリをゼロから生成する必要があります。このリポジトリには、論文の主要な実験結果を再現するために必要なすべてのコードが含まれていなければなりません。

-

提出形式: リポジトリは、ルートディレクトリに

reproduce.shという名前のスクリプトを含まなければなりません。このスクリプトは、すべての実験を実行するための単一のエントリーポイントとして機能します。

2. データセット:

- PaperBenchは、2024年のInternational Conference on Machine Learning (ICML)から選ばれた20本のSpotlightおよびOral論文で構成されています。

- これらの論文は、12の多様なトピック(例:深層強化学習、頑健性、LLM、確率論的手法)にわたる現代のAI研究を代表するように慎重に選ばれました。(論文の表2に論文リストが掲載されています)。

- 選定基準により、論文が実質的な実験的要素を持ち、単一のマシン(GPU付き)で再現可能であり、アクセス不能な依存関係(クローズドソースモデルや人間によるアノテーションなど)に依存せず、再現に十分な詳細情報が含まれていることが保証されました。

- 著者らはまた、開発用と内部評価用の非公開セットも別途保持しています。

3. 再現ステップ:

- 結果が、提出されたコードによって真に生成されたものであり、ハードコーディングされたり、エージェントの開発環境からのアーティファクトでなかったりすることを保証するために、提出物は別の再現フェーズを経ます。

- 提出されたリポジトリは、新しい仮想マシン(Ubuntu 24.04、A10 GPU)にコピーされます。

- このクリーンな環境で

reproduce.shスクリプトが実行されます。 - 実行時間には上限が設けられています(彼らの実験では12時間。ただし、平均的なエージェントのスクリプト実行時間は5.5分でした)。

- 生成されたすべてのファイル(結果、プロット、ログ)と、スクリプトの出力を含む

reproduce.logファイルが、評価に使用される「実行済み提出物」を構成します。

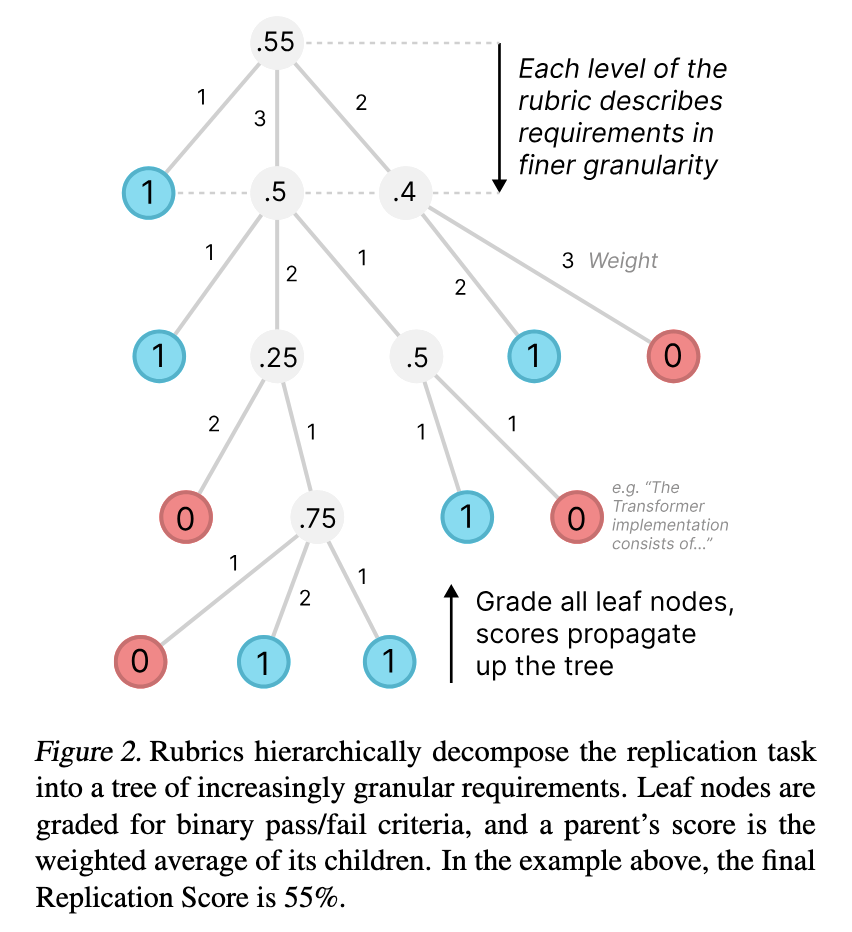

4. ルーブリック:成功を階層的に定義する

- これは間違いなく、PaperBenchで最も重要かつ労力を要する部分です。各論文について、詳細なルーブリックが、再現成功に必要な具体的な成果物を定義します。

- 著者との協働: 各ルーブリックは、ICML論文の元の著者の1人と共同で開発され、正確性、現実性、そして最も重要な側面への焦点を保証します。

- 階層構造: ルーブリックはツリー構造になっています(図2で視覚化)。ルートは全体的な再現を表します。各ノードは、要件をより詳細なサブ要件(子ノード)に分解します。

- 粒度: 分解は、リーフノードが正確で個別に採点可能な基準(例:「コードはk-embeddingsにユークリッド距離を用いてTransformerを実装している」)を表すまで続きます。PaperBenchには、20本の論文全体で合計8,316個のリーフノードが含まれています。

- 重み付け: 各ノードは、(必ずしも難易度ではなく)兄弟ノードに対する相対的な重要性に基づいて手動で重み付けされます。これにより、再現時に論文のより重要な部分を優先するエージェントが報われます。

- スコアリング: リーフノードはバイナリ(合格1、不合格0)で採点されます。親ノードのスコアは、その子ノードのスコアの加重平均です。提出物の最終的な「再現スコア」は、ルートノードのスコア(0%から100%のパーセンテージ)です。

-

要件タイプ: 部分的なクレジットを与え、より全体的な評価を提供するために、リーフノードは3つのタイプに分類されます(表1で詳述):

- コード開発: ソースコード自体が特定の要件を正しく実装しているように見えるかどうかを評価します(ソースファイル、READMEを見て判断)。

-

実行:

reproduce.shを実行したときに、特定の実行ステップが成功裏に発生したかどうかを評価します(reproduce.sh、reproduce.log、ソースコードを見て判断)。 -

結果一致:

reproduce.shによって生成された最終的な出力が、論文で報告された期待される結果と一致するかどうかを評価します(生成されたファイル(CSV、プロット、ログなど)およびreproduce.sh、reproduce.logを見て判断)。

5. LLM評価者:スケーラブルな評価を可能にする

- 手動での採点は非現実的です。著者らは、評価を処理するために SimpleJudge と呼ばれるLLMベースの自動評価者を開発しました。

-

仕組み: SimpleJudgeは、ルーブリックの各リーフノードを独立して採点します。

- 論文のMarkdown、完全なルーブリック構造(JSON形式)、特定のリーフノードの要件テキスト、および実行済み提出物からの関連ファイルを受け取ります。

- コンテキスト制限を管理するために、提出ファイルをフィルタリングします。コード開発/実行ノードの場合、ソース/ドキュメントファイルを関連性でランク付けし、上位10個を含めます。結果一致の場合、再現中に作成された出力ファイルに焦点を当てます。

- 要件が満たされているかどうかを評価し、バイナリスコア(0または1)とその理由を提供するようにプロンプトされます。

-

評価者の評価(JudgeEval): SimpleJudgeはどの程度優れているのでしょうか?著者らは、評価者を評価するために特別に別のベンチマーク、JudgeEval を作成しました。

- 彼らは、論文のサブセットについて、いくつかの部分的な再現の試みを作成しました(一部はゼロから、一部は著者のコードを修正して)。

- これらの試みは、ルーブリックのリーフノードに対する正解ラベルを作成するために、人間の専門家によって綿密に採点されました。

- 次に、SimpleJudgeの潜在的なバックエンドとして、さまざまなLLMが、この正解データに対して標準的な分類メトリクス(精度、適合率、再現率、F1)を用いて評価されました。

-

評価者のパフォーマンス: 彼らの結果(表3)は、

o3-mini(OpenAIのモデル識別子、おそらくGPT-3または類似のバリアントを指す)に推論努力を「高」に設定したものが、最もコストパフォーマンスに優れており、JudgeEvalでF1スコア0.83を達成し、論文評価あたりの推定コストは66米ドルであることを示しています。GPT-4oも同様のF1(0.84)を達成しましたが、コストは約2倍(120米ドル)でした。著者らは、主要なPaperBenchの結果の評価者としてo3-mini-highを使用しました。層別化された結果(表8)は、評価者が要件タイプ全体で比較的良好に機能することを示していますが、コード開発ノードが最も困難(F1=0.72)であり、結果一致ノードが最も容易(F1=0.94)であることも示しています。

6. PaperBench Code-Dev:軽量版

- 完全なPaperBench評価には、かなりのエージェント計算リソース(再現のためのGPUアクセスを含む)と無視できない評価コストが必要であることを認識し、著者らは PaperBench Code-Dev もリリースしました。

- このバージョンは、評価を大幅に簡素化します:

- 再現ステップを完全にスキップします。

- 評価者は、提出されたソースコードに基づいて、「コード開発」リーフノードのみを採点します。

- これにより、評価中のGPU実行の必要がなくなり、評価コストが約85%削減されます(o3-miniを使用した場合、論文あたり推定10米ドル)。

- 著者らは、Code-Devでのパフォーマンスは完全なベンチマークでのパフォーマンスと弱い相関しかない(ピアソンr=0.48)と指摘しており、能力の予備的でノイズの多い指標として使用するのが最善であることを示唆しています。

7. ルール:

- エージェントはインターネットを閲覧することが可能です。

- 各論文についてブラックリストに載っているリソース(特に、元の著者のコードリポジトリや既知のオンライン再現)にアクセスすることはできません。事後モニターがエージェントのログで違反をチェックします。

主要な結果

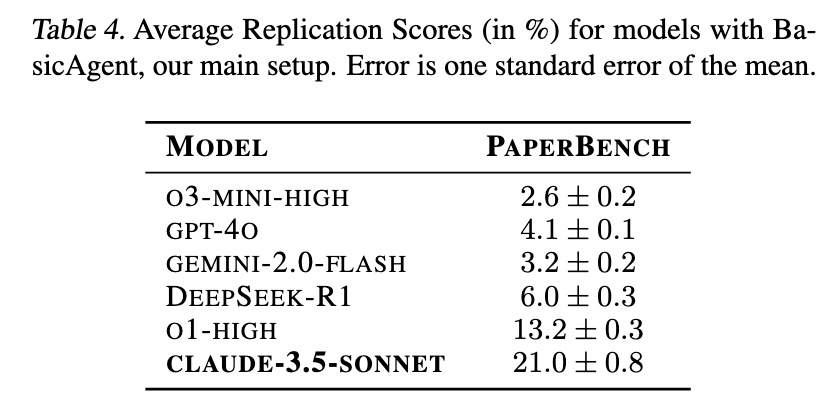

この論文では、PaperBenchフレームワークを使用したいくつかの最先端AIモデルの評価結果が示されています。

エージェント設定(BasicAgent):

- Inspect AIの

basic-agentに基づくシンプルなエージェントスキャフォールドが使用され、ReActスタイルのツール使用ループを実装することができました。 - 提供されたツール:Bashシェル、Python実行、Webブラウザ、ページ分割されたファイルリーダー。

- エージェントは、A10 GPUアクセスとインターネット接続を備えたDockerコンテナ(Ubuntu 24.04)で実行。

- テストされたモデル:GPT-4o、o1、o3-mini、DeepSeek-R1、Claude 3.5 Sonnet (New)、Gemini 2.0 Flash。エージェントには12時間の実行時間制限が付与されました。

主な発見(BasicAgent):

- Claude 3.5 Sonnet (New) が最高性能で、平均再現スコア**21.0%**を達成しました(表4)。

- OpenAIの

o1(高推論)が次点で**13.2%**でした。 - 他のモデルは10%未満で、

o3-mini-highは2.6%でした。 - 全体的なスコアは低く、現在のモデルにとってタスクの難しさを示しています。

-

エージェントの振る舞い: 手動検査により、ほとんどのモデル(Claude 3.5 Sonnetを除く)が実行を早期に終了する傾向があることが明らかになりました。多くの場合、完了を主張したり、解決不可能な問題に直面したと主張したりして、利用可能な時間を最大限に活用したり、長期的なタスクに対して効果的に戦略を立てたりすることに失敗していました。

o3-miniは基本的なツールの使用に頻繁に苦労していました。

IterativeAgentの発見:

- 「早期終了」問題に対処するために、著者らは修正されたスキャフォールド、IterativeAgent をテストしました。これは「タスク終了」ツールを削除し、全期間にわたって段階的なステップバイステップの進捗を促すプロンプトを使用しました。

- 結果(表5):これにより、

o1(24.4%へ)およびo3-mini(8.5%へ)のスコアは大幅に向上しましたが、Claude 3.5 Sonnetのスコアは低下しました(16.1%へ)。これは、エージェントスキャフォールドとプロンプト戦略への高い感受性を示唆しています。 - IterativeAgentを使用した

o1の36時間の延長実行では、**26.0%**に達しました。

PaperBench Code-Devの結果:

- IterativeAgentを使用して、

o1は軽量版のPaperBench Code-Devバリアントで**43.4%**のスコアを達成しました(表6)。この高いスコアは、モデルが現在、実行や結果一致よりもコード開発に優れているというJudgeEvalからの発見を反映しています。

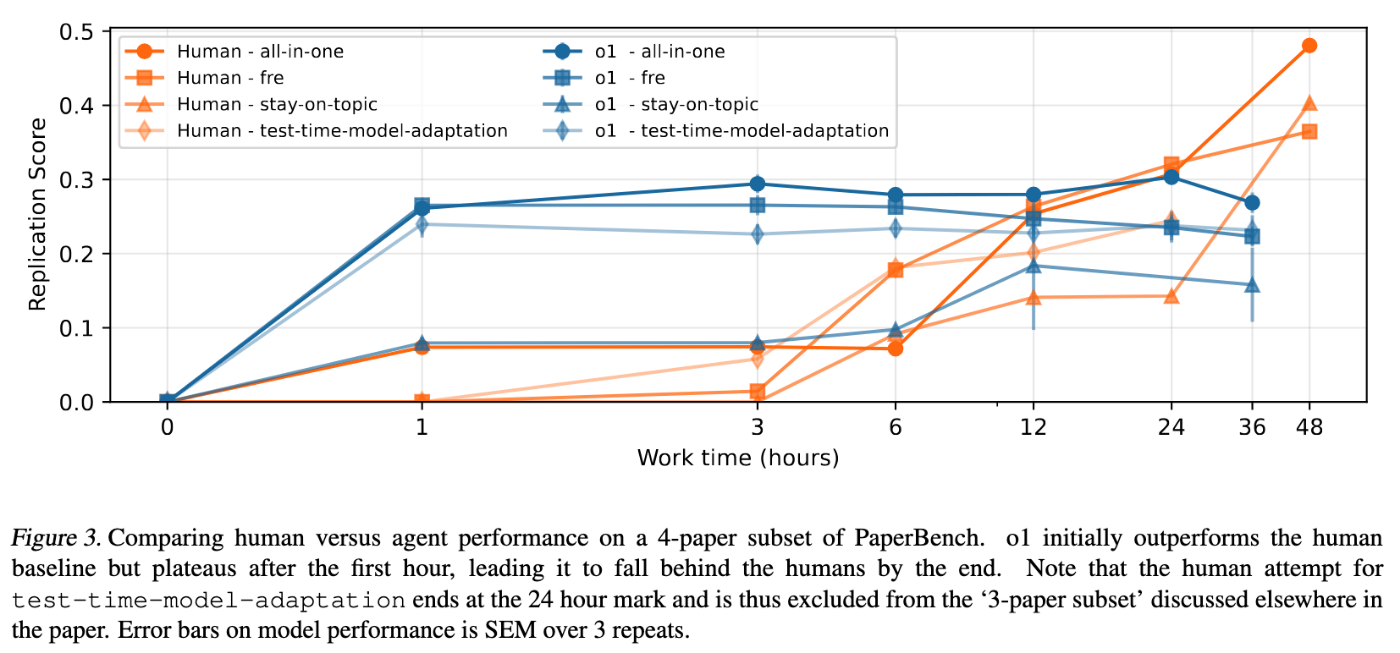

人間ベースラインとの比較:

- 著者らは、AIエージェントと同様の条件下(A10 GPUアクセス、数週間にわたって追跡された48時間の作業時間、同じ論文/追補、ブラックリスト違反なし)で、8人のML博士課程の学生を募集し、4つの論文のサブセットで再現を試みました。彼らは、論文ごとに3つの独立した試みのうち最高のスコアを測定しました。

- 彼らは、この人間のパフォーマンスを、

o1(IterativeAgentを使用)の36時間の延長実行と比較しました。 -

重要な洞察(図3):

o1は当初、人間を上回り、最初の1時間で迅速にコードを作成しました。しかし、AIのスコアは急速に停滞しました。人間は、おそらく論文の理解に時間を費やした初期期間の後、着実に改善し、24時間マークの後にはAIのスコアを大幅に上回りました。同じ3論文サブセットにおいて、48時間後の最良の人間の試みは41.4%に達したのに対し、o1は26.6%でした。

Impact StatementとLimitation

Impact Statement:

- 測定: PaperBenchは、AIシステムが複雑な自律的ML研究タスクを実行する能力を測定し、追跡するための具体的(ただし困難な)方法を提供します。

- 安全性とアライメント: 最先端モデルの自律的能力を理解し、監視しようとする組織にとって、リスク評価や備えのフレームワークに情報を提供する貴重なツールを提供します。

- 加速: PaperBenchでの高性能は、MLや潜在的に他の分野での科学的発見を真に加速できるAIシステムへの進歩を示す可能性があります。

- オープンソース: コードをオープンソース化することで、著者らはAIエージェントの能力と評価方法に関するより広範な研究を可能にします。

- 二重用途: 論文のインパクトステートメントは、PaperBenchが測定するまさにその能力(自律的な研究再現)が、AIの進歩を急速に加速させ、慎重に管理されなければ安全対策やガバナンスを追い越す可能性があることを認めています。

限界(著者によって認められている):

- データセットサイズ: ルーブリックには数千の評価ポイントが含まれていますが、ベンチマークはわずか20本の論文に基づいています。より広範なセットが理想的ですが、作成にはコストがかかります。

- ルーブリック作成のボトルネック: 高品質で著者検証済みのルーブリックを作成することは、非常に労力がかかり(論文あたり「数十時間」)、深い専門知識が必要です。これにより、データセット作成プロセスのスケーリングや複製が困難になります。著者らは、将来の研究では、ルーブリック生成のためのモデル支援や批評を探求する可能性があることを示唆しています。

-

LLM評価者の不完全さ:

o3-mini評価者は良好なパフォーマンス(0.83 F1)を示しますが、完璧ではなく、非決定的です。評価者の信頼性を向上させ、潜在的に敵対的な提出物に対してストレステストを行うためには、今後の研究が必要です。著者らはまた、大幅に低いコストと引き換えにルーブリックの粒度をいくらか犠牲にする将来の方向性として、「プルーニングされたルーブリック評価」(付録H)を実験し、有望な初期結果を見出しています。 -

コスト: 完全なPaperBench評価の実行は、計算コストが高くなります(GPUでのエージェント実行、LLM評価者のトークンコスト)。12時間の

o1実行にはAPIクレジットで約400米ドル、加えて評価に論文あたり平均66米ドルかかります。PaperBench Code-Devはこれを大幅に削減しますが、提供される全体像は不完全です。 - 汚染リスク: 時間が経つにつれて、モデルがPaperBenchの論文やその解決策で訓練され、スコアが不当に高くなる可能性があります。ICML 2024論文の現在の新しさは、今のところこれを緩和しています。

- 仕様ゲーミング: ルーブリックは慎重に設計されていますが、その複雑さから、エージェントが真に再現することなく高得点を得るための抜け穴を見つける可能性(仕様ゲーミング)、あるいは戦略的にパフォーマンスを低下させる可能性さえ残されています。

結論

PaperBenchは、AIエージェントの現実世界における研究能力を評価する上で重要な一歩を表しています。エージェントに最先端のICML論文をゼロから再現させ、自動化されたLLM評価者を使用して詳細な著者検証済みルーブリックに対して評価することで、ML R&DにおけるAIの自律性に関する厳格かつ包括的な評価を提供します。

初期の結果は示唆に富んでいます。Claude 3.5 Sonnetのような現在の最先端モデルは非自明な能力を示し、平均スコア21%を達成していますが、タスクの完全な複雑さを習得するにはまだ程遠い状況です。モデルは、関連するコードスニペットを迅速に生成できたとしても、特に長期的な計画、持続的な実行、最終的な結果の一致に苦労しています。人間の専門家は、最初は遅いかもしれませんが、現在、より長い時間スケールで完全な再現プロセスを理解し実行する上で優れた能力を示しています。

PaperBenchは、AIの能力が進歩し続ける中で、進捗状況を追跡し、限界を理解し、安全研究に情報を提供するための貴重なツールをコミュニティに提供します。特にルーブリックの作成と評価のコストとスケーラビリティに関する課題は残っていますが、PaperBenchはAI評価の未来のための重要な基盤を築くものでしょう。

Discussion