産業ロボットから汎用基盤モデルまで:AI融合による変革と課題

0. はじめに

AIRoAテックブログ

前回の記事に引き続き、今回からは具体的な技術や取り組みについて紹介していければと思います。改めて、前回の記事ではAIRoAとは?コンペでの各チームのテーマは?などについて記載されておりますので、ぜひご覧ください!

現代におけるロボティクス

ここ近年、ロボティクスが再び大きな注目を集めています。 2024年、OpenAI がロボティクス研究へ再参入し、TeslaのOptimusも家庭向けロボットの実証を進めています。医療用ロボットによる微細手術、高齢者支援、災害救助や宇宙探査など、適用領域は一段と拡大しています。

OpenAI's Leap into Humanoid Robotics

ロボティクス市場は 2024 年に 784 億ドル、2029 年には 1,652 億ドルへと年平均成長率(CAGR)16.1 %で拡大すると予測されています。[1]

この成長率は、スマートフォン市場(CAGR 3.5%)[2]や自動車業界(CAGR 3.2%)[3]といった成熟した巨大市場を大きく上回る驚異的な水準となっています。

この急伸を後押しする要因は色々挙げられますが、 ①深層学習による知覚・制御技術の飛躍、②少子高齢化による労働力不足、③産業全体のデジタル変革などが挙げられます。とりわけ人と協働し意思疎通できる知的ロボットの登場が「再びのブーム」を牽引しています。たとえば最新のマルチモーダル VLM (Vision Language Model) は「テーブルのリンゴを取って」という自然言語指示を理解し、周囲を認識して安全に実行できます。

本記事の目的

本記事では、現代におけるロボティクスの立ち位置を歴史を振り返りつつ再確認し、どのような技術的進展があり、未だどのような部分が課題で、何ができるようになったのかを認識することを目的としています。

1. ロボティクスのこれまで(産業ロボットから汎用基盤モデル)

家庭用ロボットや倉庫を走行する自律搬送車を見かける機会が増えてきたとはいえ、その劇的な進化はわずか数十年のうちに起こりました。製造ラインで火花を散らした産業ロボットの黎明期を皮切りに、用途の多様化・専門化フェーズを経て、人と肩を並べて働く協働ロボット、さらにはAIと深く融合した汎用基盤モデルへと発展しています。本節では、この短期間でロボティクスを加速させた社会的ニーズと技術ブレイクスルーに焦点を当て、各時代の技術的特徴と進化の要点をコンパクトに整理します。

各時代の概要

1960年代-1980年代:産業ロボット黎明期

この時代のロボティクスは、主に製造業での自動化が中心でした。

1969年、川崎重工とUnimationが共同開発したKawasaki–Unimate 2000が自動車溶接ラインへ配置され、熟練工約10人分の作業を代替しました。[4]

また、1980年前後には日本が世界市場の約7割を占めるまでに成長し、「産業ロボット大国」の地位を確立しました。

1990年代-2000年代:協働ロボットとAI融合

バブル崩壊後の新市場開拓として、二足歩行・家庭向けロボットが登場しました。ホンダのASIMOは人間らしい歩行とジェスチャで「ロボットが共存する社会像」を提示。[5]ソニーのAIBOは心を通わせるコンセプトで家庭用エンタメ市場を開拓し、ロボットの感情的価値を可視化しました。阪神淡路大震災(1995)後にはレスキューロボット研究も加速し、効率化だけでなく社会貢献が期待される存在へ転換しました。

2010年代-現在:協働ロボット(コボット)とAI統合の時代

1990年代–2000年代のロボット多様化に続き、2010年代からは人間との本格的な協働を実現する新たな時代が始まりました。深刻化する労働力不足とAI技術の急速な進展により、ロボットは単なる自動化ツールから「人間の協働パートナー」へと進化しています。

例えば、デンマークのUniversal Robotsは2008年に世界初の商用コボット「UR5」を発売し、安全柵不要で中小企業にも導入可能な協働ロボットの概念を確立しました。[6] 日本勢では、質量約4 kgの小型・可搬型コボット「COBOTTA」を投入し、非専門家でも直感的に操作できる環境を実現しています。[7]

また、FANUCは2019年の国際ロボット展でCRXシリーズを発表し、安全性と意匠性を両立した協働ロボットを提供しました。[8]

さらに並行して、深層学習や強化学習を応用することで視覚認識や動作計画が飛躍的に高度化し、事前プログラミングなしで未知環境へ適応するロボットが登場しました。

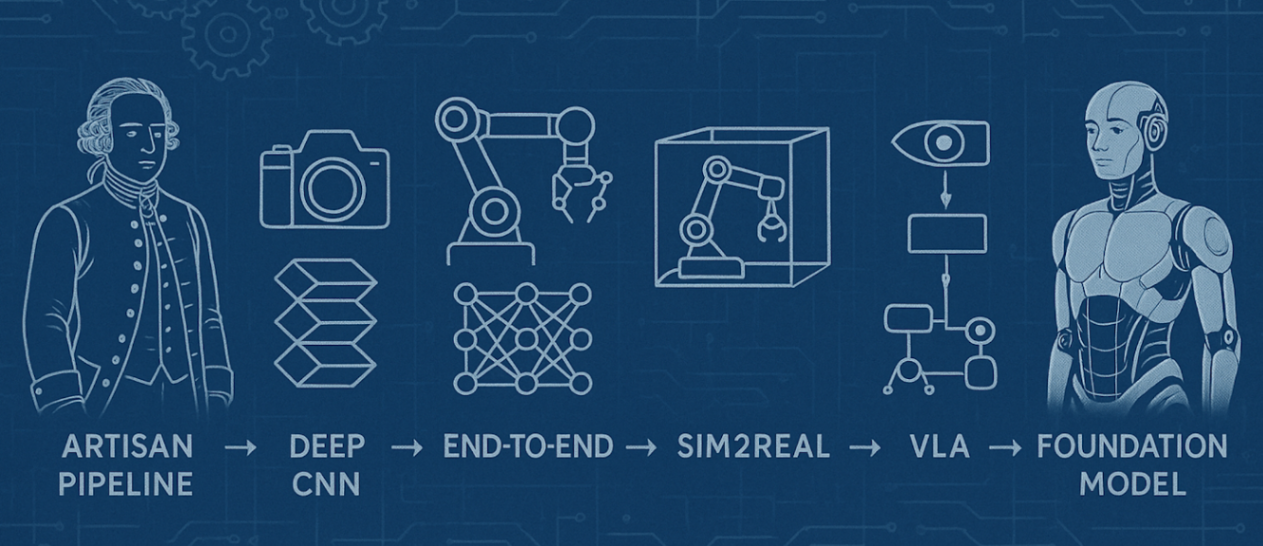

ロボティクスにおける技術的進展

ロボティクスにおけるAI革命では、「人手による設計」から「データ駆動学習」への根本的転換がありました。ここからは技術的進展に目を向けて紹介していきます。

前深層学習時代:職人技パイプラインの限界

深層学習が登場する以前、ロボットの認識と制御は手作業による特徴量設計とPD制御を積み木のように重ねた職人技パイプラインが主流でした。しかし、照明条件や背景が少し変わるだけで、システム全体の再調整が必要になるという脆弱性が存在しました。

AlexNetが示した新たな可能性

そんな中、コンピュータビジョン分野で起きた革命が、ロボティクスにも大きな影響を与えました。転換点となったのは、画像分類の歴史を塗り替えたAlexNetです。ここでは、人間が設計した特徴量よりも、データから学習した特徴表現の方が遥かに強力であることが実証されました。そしてこの洞察は、ロボティクス研究者たちに「手作業による設計から学習ベースへ」という新たな方向性を示しました。[9]

End-to-End学習

次に、AlexNetの成功に触発され、この深層学習の力を直接ロボット制御に応用する試みが始まりました。Levine らによるEnd-to-End Visuomotor Policyは、カメラ画像を入力し、そのままモータートルクを出力するCNNを実装。「目と手を同時に学習」する道筋を示し、中間表現に人間の設計思想が入り込む余地を排除しました。これにより、従来の段階的アプローチよりも柔軟で汎用性の高いロボット制御が可能になりました。[10]

カメラ画像から直接ロボットのモータートルクを出力するEnd-to-Endニューラルネットワークの構造図

Sim2Realとビッグデータの活用

しかし、深層学習の適用には新たな課題が浮上しました。深層学習モデルが高い性能を発揮するには、複雑なロボットタスクの場合、数十万から数百万回の試行錯誤データが必要となります。しかし、実際のロボットでこれを収集するには膨大な時間とコストがかかり、機械の摩耗や故障リスク、安全性の問題も伴います。この「深層学習のデータ飢餓」と「実機学習の現実的制約」という根本的矛盾を解決するため、Sim2Real技術が登場しました。Sim2Realでは、シミュレーション環境で大量のデータを安全かつ高速に生成し、そこで学習したモデルを実世界のロボットに転移することができます。[11]

シミュレーション学習から実機適用へ転移

LLMとロボティクスの融合

2020年代に入ると、自然言語処理分野で起きたLLM革命が、再びロボティクスに新たな可能性をもたらしました。GoogleのPaLM-SayCanは、「何をすべきか」の高次判断をLLMが担当し、「どうやるか」の具体的実行をロボットが判断する二段階システムで高い成功率を達成しました。この融合により、ロボットは初めて自然言語による抽象的な指示を理解し、それを具体的な行動に変換できるようになりました。[12]

Vision-Language-Actionの統合

LLMとロボティクスの融合がもたらした可能性をさらに発展させたのが、マルチモーダル学習の進歩でした。RT-2はVision-Language Model(VLM)をVision-Language-Action(VLA)へ拡張し、Web規模の知識をロボット制御に転移することで、ゼロショットで未知タスクに対応できる汎用性を実現しました。これにより、ロボットはインターネット上の膨大な知識を活用して、明示的に学習していないタスクにも対応できるようになりました。[13]

次世代基盤モデルの誕生

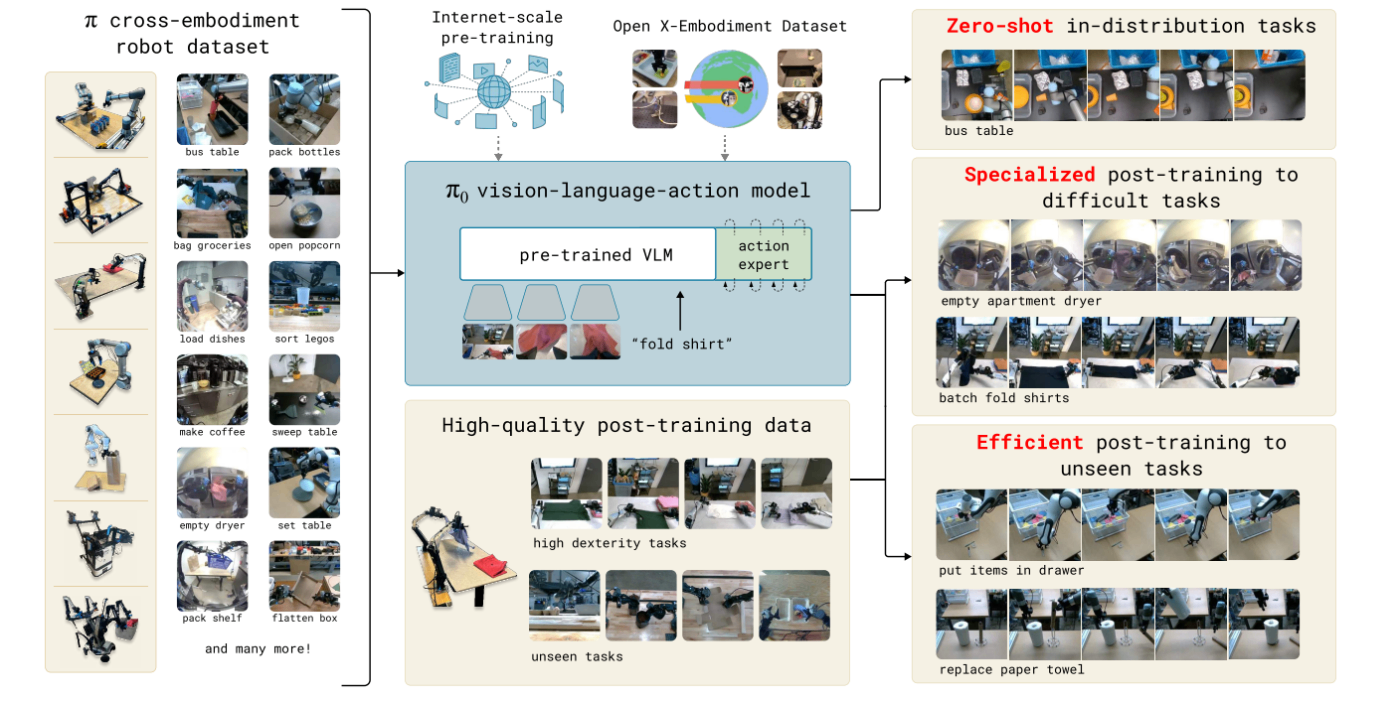

そしてついに、これまでの技術的蓄積が結実し、汎用ロボット基盤モデルが登場します。Physical Intelligence のπ0は、テキスト・画像・動作を統合した汎用ロボット基盤モデルとして登場。様々なロボット形態で汎用的なタスクを実行できる能力を示しました。[14]

π0アーキテクチャ

さらに、2025年3月にはNVIDIAのGR00T N1.5が発表され、3Bパラメータで言語コマンド理解において高性能を達成。Hugging Faceでの公開により、世界中の研究者が最先端のロボット基盤モデルにアクセス可能になりました。[15]

2. ロボティクスの特徴およびはじめ方

これまで産業ロボットからAI融合による基盤モデルまでの発展を概観してきました。ここでは、従来の機械学習・深層学習とロボティクスの本質的な違いを明らかにし、ロボティクス研究へのアプローチについて記載します。

機械学習・深層学習とロボティクス

機械学習・深層学習は、入力と出力のあいだにある規則性をデジタル空間で学習・変換する技術です。たとえば画像分類では「画像 → ラベル」、翻訳では「テキスト → テキスト」というように、処理も結果もビット列で完結します。

一方、ロボティクスはこれと異なり、センサーから得た観測(カメラ画像・力覚など)を物理世界の動作、具体的にはモーターやアクチュエータへの制御信号へと変換しなければなりません。このとき、ハードウェアの個体差・環境ノイズ・摩耗や温度変化といった物理法則の制約がモデル性能に直接影響します。

そのため、たとえ大規模な基盤モデルやオープンデータがあっても、実機に展開するときには環境固有の差異が大きな壁となります。

結果として 現場ごとに追加データを大量収集する必要が生じ、実験の再現性を保つのも難しい、さらに「ある環境で機能したモデルが別環境でも同じように動く」という汎用性の確保が依然として大きな技術課題です。

ロボティクス研究・学習を始めるために

AIとロボティクスは、それぞれの強みを補完し合うことで応用範囲を飛躍的に広げられる相性の良い領域です。近年は Gazebo[16]やIsaac Gym[17]などのオープンソース・シミュレーターに加え、RoboNet[18]といった公開データセット、さらには RT‑2やGR00TなどのVLAが整備され、少量データを用いた微調整も手軽に試せるようになりました。こうした仮想環境を活用すれば、コストを抑えつつ高速に試行錯誤を重ねる失敗から学ぶサイクルを回しやすくなります。

一方、シミュレーションで得た知見を実機に落とし込むハードルも大きく下がっています。卓上ロボットアームは数万円、ArduinoやRaspberry Piなどのマイコンは数千円で入手できるため、個人でも自宅に小規模な実験環境を構築できます。大学や企業の研究室であれば、トヨタ社のHSR[19]などの協働ロボットを研究目的で比較的容易に借用する選択肢も広がっており、学術的にも産業的にも実機検証に取り組みやすい状況が整っています。

実践にあたっては、まず予算や設置スペース、可搬重量などの制約を整理し、利用可能なシミュレーターと実機を見極めることから始めます。シミュレーション環境で制御アルゴリズムやモデルの適合性を検証しつつ、公開データセットを活用して環境特化のファインチューニングを並行して進めると、実機導入時のリスクを最小化できます。実機側ではRGB‑Dカメラやフォースセンサを組み合わせた小規模なセットアップから着手し、JetsonやクラウドGPUを用いて推論パイプラインを実装することで、センシングから制御までを一気通貫で把握できます。また、安全規格なども早期に確認し、非常停止装置や仮想フェンスを設計段階から盛り込んでおくと、後戻りを防げます。

3. さいごに

本記事では、ロボティクスのこれまでを振り返りながら、深層学習やAIがもたらした技術革新とその融合、課題を整理しました。

物理制約という根本的な壁は確かに存在しますが、Sim2RealやVLAモデルなど最新技術の登場により更なる可能性が今後広がるでしょう。また、実機に触れる楽しさもロボティクスならではの魅力だと思います。最後まで読んでいただきありがとうございました!

-

https://www.bccresearch.com/market-research/engineering/robotics.html ↩︎

-

https://www.mordorintelligence.com/industry-reports/smartphones-market ↩︎

-

https://www.marketresearchfuture.com/reports/automotive-industry-7683 ↩︎

-

https://robotics.kawasaki.com/userAssets1/files/en/Half_a_century_of_Kawasaki_Robotics_EN.pdf ↩︎

-

https://global.honda/en/newsroom/news/2000/c001120b-eng.html ↩︎

-

https://www.denso-wave.com/en/robot/product/collabo/cobotta.html ↩︎

-

https://www.fanucamerica.com/news-resources/fanuc-america-press-releases/2021/12/23/new-crx-10ia-robot-raises-the-bar-in-collaborative-technology ↩︎

-

https://proceedings.neurips.cc/paper_files/paper/2012/file/c399862d3b9d6b76c8436e924a68c45b-Paper.pdf ↩︎

Discussion