【解説】Gemini 2.0 Flash × bolt.diy で超低コスト&制限フリーなAIエージェント開発を始める方法

bolt.diyとは何か?

AI搭載Web開発ツール「Bolt.new」のオープンソース版。ローカル環境やDockerで自由に構築可能。自前のAPIキーを差し替えて使えるのが最大の特徴。

Gemini 2.0 Flash

Googleが提供している言語モデルの一つ。今ホットなAIの1つ(主に個人開発などに適応しやすい意味でも)

「高速応答」や「コスト面での優位性」「100万トークンの巨大コンテキスト」が強み。

- 入力トークン上限が非常に大きく、かつ推論速度も早い

- 料金体系が安価かつ細かいステップで課金される(無料枠も存在)

本記事では、この二つを組み合わせて利用し、「安く」「爆速」でAI支援の開発を行う流れをざっとご紹介します。

bolt.diyとは? なぜオープンソース版を使うとお得なのか? bolt.newとの違い

bolt.new

ブラウザでフロントからバックエンドまで書ける革新的なAI開発プラットフォーム。月額制サブスクが存在し、有料プランだと大きめのトークン枠が使える。

bolt.diy

そのbolt.newの「オープンソース版」。リポジトリをクローンしてローカル実行し、APIキーさえ手元にあればどんなLLMでも使えるというメリットがある。

独自に用意したLLM(例: DeepSeekやOpenAI GPT-4o、Gemini2.0など)を選択可能

費用:実行にかかるのは自分が契約している各LLMのAPI料金のみ。

bolt.new本体のサブスク費用は不要。

- 公式リポジトリをクローンして、Docker Composeで一発起動が可能

- または、Node.jsとpnpmを直接インストールしてローカルで起動もできる(WindowsならWSL利用推奨)

事前準備

- Docker(またはNode.js + pnpm)をインストール

- Windowsの場合はWSL経由でDockerを導入するとスムーズ

- Git のインストール

- git cloneを使うために必要

bolt.diyのセットアップ

- リポジトリのクローン

git clone https://github.com/stackblitz-labs/bolt.diy.git

cd bolt.diy

- pnpm で依存関係をインストール

npm install -g pnpm # pnpmが未インストールの場合

pnpm install

- Docker利用の場合

npm run dockerbuild # Development用

docker-compose --profile development up

- ローカル(Node.js)起動の場合

pnpm run dev

ブラウザでアクセス

通常http://localhost:5173などが表示されるので、そこにアクセス

Gemini 2.0 FlashのAPIキーを設定

- Google Cloud(Vertex AIやGenerative AI Studio)でプロジェクト作成

- Googleアカウントでログインし、AIモデル開発のダッシュボードにてGemini 2.0 Flashを選択

- APIキーを取得を選択

bolt.diyのLLM設定画面を開く

ページ左上か右上あたりに「LLMを選択」あるいは「APIキーを入力」ボタンがある(UIによって異なる)

-

Geminiを選択し、取得したAPIキーを入力

例)Model: “Gemini 2.0 Flash” -

API Key欄に発行したキーをペースト → 保存

以上で、Gemini 2.0 Flash × bolt.diy の連携が完了。

あとはbolt.diy上でプロンプトを入力するだけで、Geminiモデルを使ったチャットやコード生成が可能になります。

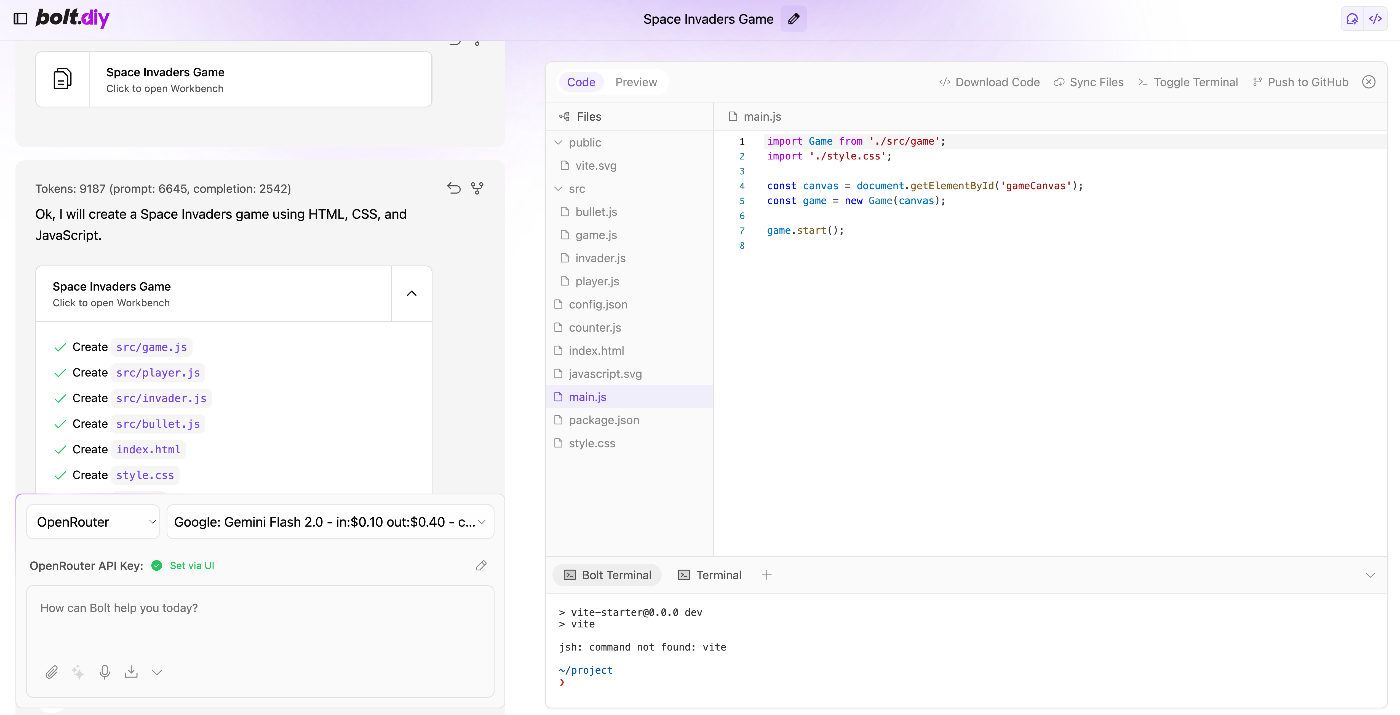

実際に試す:コード生成のデモ

サンプル:Next.jsでTodoアプリを作る

Next.jsでシンプルなTodoアプリを作成。タスクの追加・削除ができ、全タスクを一覧表示する機能を追加。

- 実行すると、右ペインにてGemini 2.0 Flashが高速でコード生成を開始

- 生成完了後、プレビューを開き確認

- 必要に応じて、「削除したタスクの復元機能を追加」など追記し、より機能を充実

実際の使用感

生成スピード

Gemini 2.0 Flashは「出力速度がかなり高速」で、笑ってしまう。deepseekと比較するとかなりの差を感じる

価格面

大規模なコード生成・大量のトークン使用でも、思った以上に課金額が抑えられる

品質

流石にClaude3.5Sonnet等の現在の主流モデルと比べれば劣る印象はあるが、前モデルGemini1.5flashと比べれば全然いい感じ。

料金の目安と注意点

Google側の料金体系

2025年2月時点で、Gemini 2.0 Flashはインプット・アウトプットともに非常に安価なレートが設定されている。

-

無料枠も一定数あり:1日数百~数千回のリクエストなら追加コストゼロで使える可能性も

-

bolt.diy自体は無料

- 課金が発生するのは接続先のLLM API分のみ

-

トークン使用量モニタリング

- 大規模データを一度にプロンプトとして投げる場合、利用上限(コンテキスト100万トークン)に注意

- APIキーのレート制限・リクエスト上限にも注意が必要(Google Cloudコンソールで確認)

Gemini 2.0 Flash × bolt.diyはこんな方におすすめ

-

コストを極力抑えたい

APIコストがかなり節約できるのが最高。使い放題でも他のサービスなどと比べれば安く使うことができる。使用制約を読む必要があるが無料モデル(実験版)を使って動かすこともできるのはいい -

高速で開発を回したい

Chatリクエストやコード生成がサクサク動くので、試作→修正の反復がスピーディ -

自前環境で自由に動かしたい

bolt.diyはオープンソースかつDocker対応。会社PCでも個人PCでもセットアップしやすい

まとめ

LLMの性能が向上しコンテキストデータも増えてくれば来るほど、このboltなどのツールも強力になるわけですから今後が楽しみですね

Discussion