🤗

llama.cppでHugging Faceのモデルを直接利用する

ローカルLLMについて初心者すぎて使い方がわからなかったので、備忘録的に書き残しておきます。

なお、私が利用しているPCはMacBoolPro M3 Maxです。

llama.cppのビルド

Curlを利用するように設定してビルドする必要があります。

git clone git@github.com:ggerganov/llama.cpp.git

cd llama.cpp

mkdir build

cd build

cmake .. -DGGML_METAL=ON -DLLAMA_CURL=ON

cd ..

cmake --build build --config Release

あとは build/bin/ にパスを通せば良いです。

Hugging Face

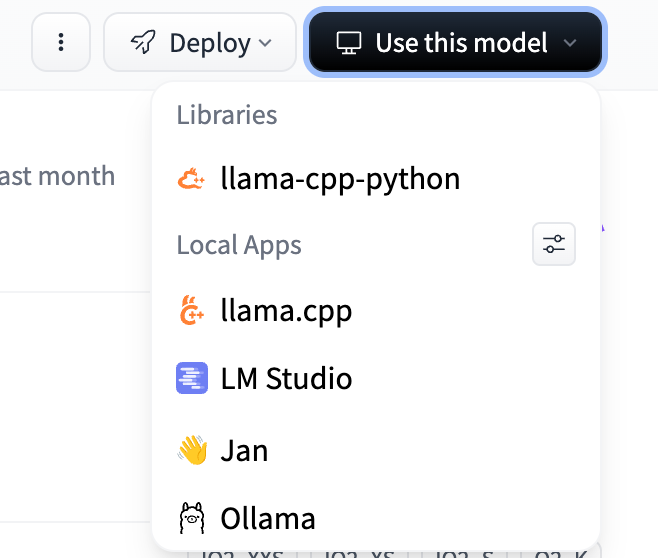

Hugging Faceには色々アップロードされていますが、以下のスクリーンショットにある Use This Model ボタンから簡単に実行すべきコマンドが分かります。

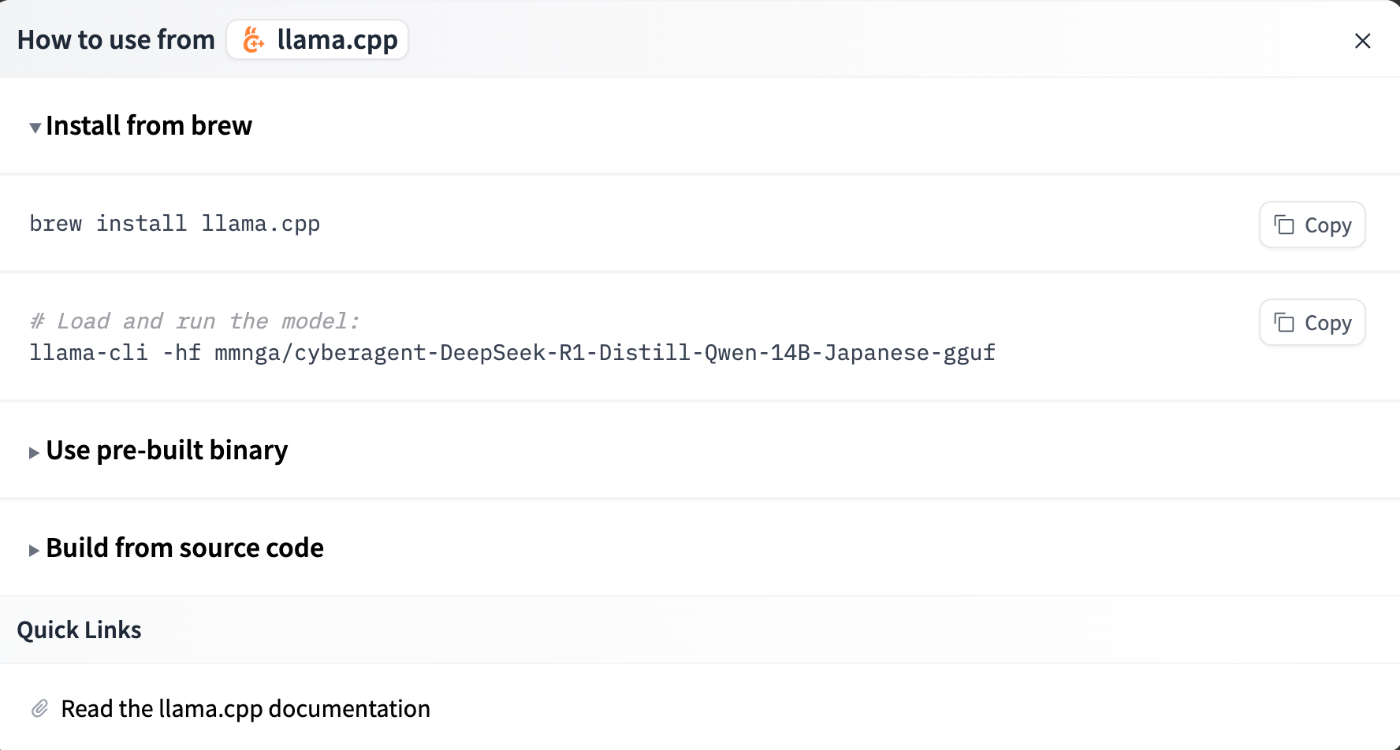

ここで llama.cpp を押すと以下のような画面が出ますので、表示されているコマンドを実行すると勝手にモデルをダウンロードして実行してくれます。

これで素敵なローカルLLM生活を楽しみましょう!

Discussion