☺️

CerebrasのAPIが利用可能に

はじめに

以前記事でご紹介したCerebrasについて、APIのWaitlistに登録していました。 昨日(2024/10/9)、ついにAPI利用の招待メールが届きました!

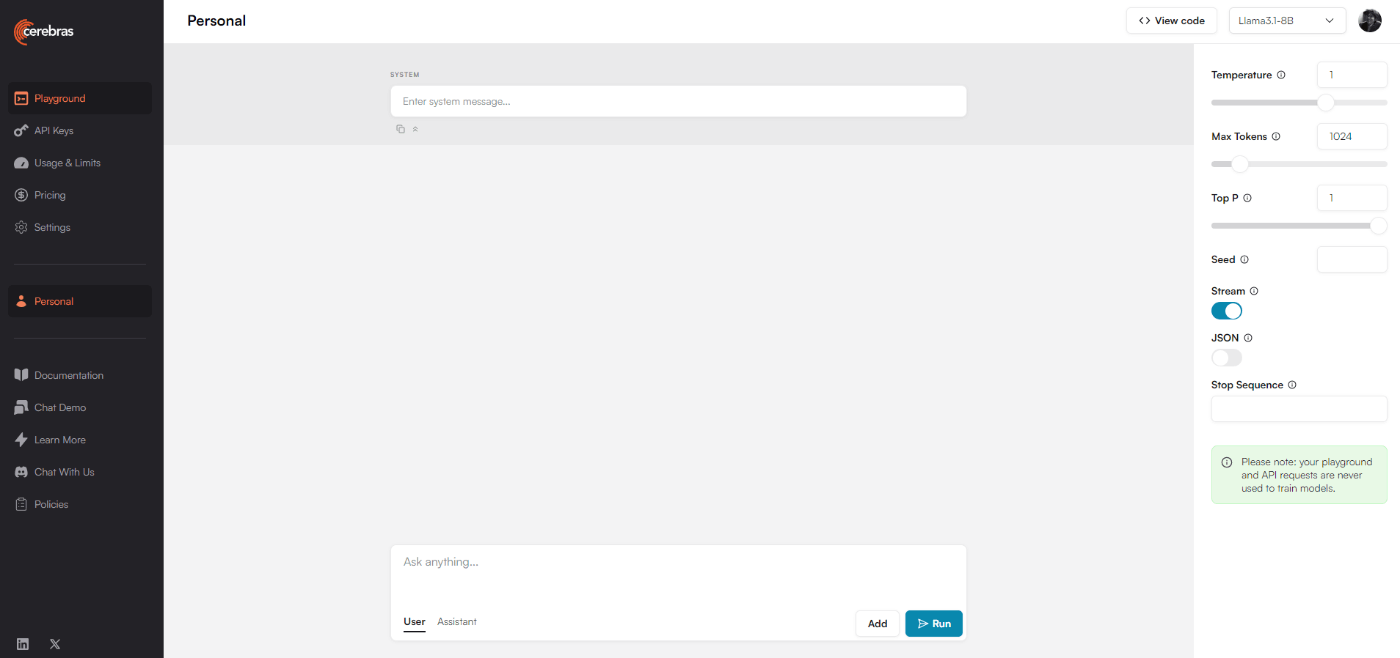

APIのPlayground画面

API利用可能になると下記URLが開けるようになります。

開くとPlayground画面になり、APIをチャット経由で試すことができます。

試しにPlaygroundで質問してみましょう。

速いですね!

費用はどのくらいか

現状無料プランのみのようです。

有料の場合は従量課金で、Llama3.1 8Bで1M tokenあたり$0.2、Llama3.1 70Bで1M tokenあたり$1.2となるようです。GPT-4o miniと比べると高いですが、現時点で現実的なコスト感かなと思いました。

ColabでPythonからAPI呼び出しをためしてみる

Cerebras社のドキュメントにサンプルコードがあり、参考にしてPythonを組んでみました。

pip install cerebras_cloud_sdk

CEREBRAS_API_KEY="XXX"

import os

from cerebras.cloud.sdk import Cerebras

client = Cerebras(

api_key=CEREBRAS_API_KEY

)

chat_completion = client.chat.completions.create(

messages=[

{

"role": "user",

"content": "札幌のおすすめのスポットを5つ教えて",

}

],

model="llama3.1-70b",

)

# LLMからのResponse結果のみを出力

print(chat_completion.choices[0].message.content)

実行してみた結果がこちら。

普通に爆速ですね。笑

さいごに

いかがでしたか。高速にLLMの回答を出力できるCerebrasでついにAPIが利用できるようになった記事を書きました。生成スピードがあがることでLLMの利用用途が広がっていくので、今後の動きに注目ですね!

Discussion