ローカル環境でサクッとLLMを動かせるようになった!

使ったツール

GPUStackというツールです。

ローカルでLLMを使うのに、入れれば色々なLLMなLLMを簡単に導入・管理できるツールです。

どんなツール?

ローカル環境に導入して、LLMのモデルを入れたり、使ったりできるツールです。

GUIでもCLIでも使えます。

つよつよな使い方をすると、導入されたマシンのGPUを抽象化して統合管理し、

複数のLLM用に割り当てたりできるようです。

(この辺はまだちゃんと触ってなくて分かってない)

こんな感じに、ノリでぽちぽちしたらローカルLLMを入れられる! 👇

入れ方は?

とりあえずこのコマンドをコマンドライン上で打って、

curl -sfL https://get.gpustack.ai | sh -s -

分かんなかったらChatGPTとかに全コピーして、

「なんかエラー出たんだけど解決方法教えて」

とやって出てくる手順でいけました。

詳細な手順は下記ページ👇

環境

- ハード:MacBook(M1,2020) ※WindowsやLinuxもいけるみたいです。

- OS:macOS 15.4(24E248)

- Python:3.10.11

- ソフト:GPUStack v0.5

- 覚えてる限りの前提条件:

- Macにhomebrewというやつが入っていること

- 導入するローカル環境のpythonが3.10~3.12であること

- macOSが14以上であること

- ※詳細な環境の要件はここに載ってます。仕様のリンク

- 使用したLLMモデル:

- llama3.2

- deepseek-r1

- stable-diffusion-v2.1-turbo

感想、ローカルで簡単に動かせてすごい!面白い!

ツール入れてサクッと動かせる感がすごい!

そして、 ローカルでLLMが動く!というのが素直に感動!

llama3.2は、こんな感じに動いてくれました。

# 命令

日本語で自社製品「IT教育くん」を営業するメール文章を作成してください。

# 役割

あなたはプロフェッショナルな営業マンです。お客さんの立場に立った優れたメール文章を作成することができます。

# 製品の特徴

- 名称は「IT教育くん」

- 教育現場における、学期試験の実施や採点を自動で行うツール

- 導入することにより、試験を行う先生の負担を減らし、正確性を上げることができる。

---

「IT教育くん」 お客様へのごサポートに取り組む

ご自身に興味がある製品「IT教育くん」をぜひご購入してください。

【製品の特徴について】

* 教育現場における学期試験の実施や採点を自動で行うツールです。

* 導入することにより、試験を行う先生の負担を減らし、正確性を上げることができます。

【ご購入の手続きについて】

* [製品の説明文][link:製品の説明文]

* [ご購入の方法][link:ご購入の方法]

* [製品の注意事項][link:製品の注意事項]

【ご質問の回答】

ご質問の場合には、[製品のパフォーマンスについて][link:パフォーマンスについて]をご確認ください。

【ご返信の手続きについて】

ご返信の場合には、[製品のパフォーマンスについて][link:パフォーマンスについて]をご確認ください。

---

上記は、自社製品「IT教育くん」の営業メールの例です。自社製品に興味がある場合は、ご自身の inquiries に対して contact することができます。

---

営業担当者:[名前]、[住所]です。

---

製品の詳細には、ご自身の inquiries に対して contact することができます。

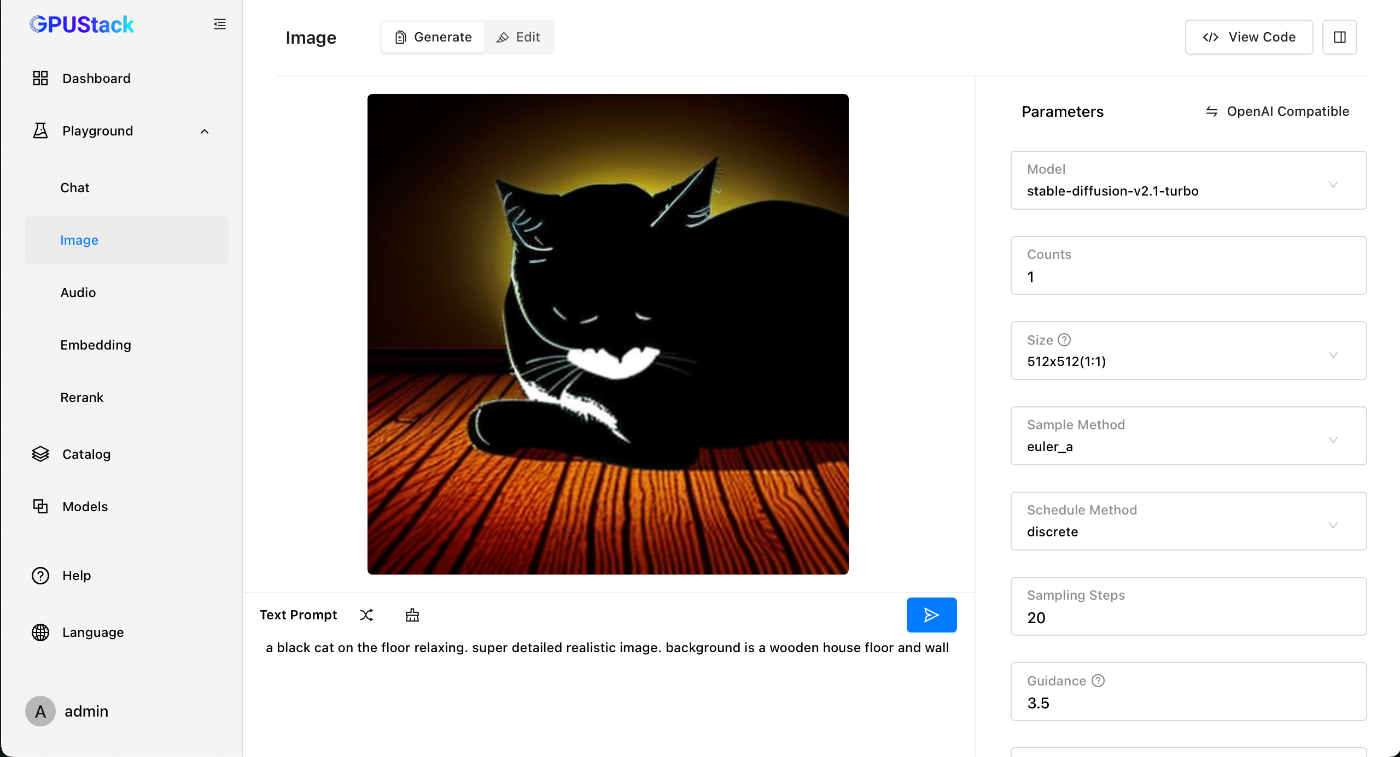

画像生成もこんな感じ。黒猫を出しました。

stable-diffusion v2.1で生成。

今後に期待な点

まず、テキストモデルの使い勝手の良さですね。

(これは単純にモデル自体の進歩具合だと思うのですが。)

もっと言うと最近の生成AIに顕著な、

「痒いところに手が届く」感じ、

「いい感じに意図を汲み取ってよしなにやってくれる」感じ。

llamaもガチガチにプロンプトを組んだら使えそう感はあるのですが、

やはりChatGPTとかClaudeとか、

ネット経由で使えるLLMの爆速進化具合に慣れちゃうと、

そういうふうに使えたらなという欲が出てきちゃいますね。

そして、画像生成の精度と速度。

(これも単純に、そもそも自分のMacで新しめのモデルを使えなかったとか、LLMのモデル自体の性能や、マシンパワーの問題かもですが。)

1枚の画像生成に4分くらいかかってました。

現行のChatGPTの生成(高精細で1枚1分かからないくらい)に慣れちゃうと、

そういうのを求めちゃうのが人間のサガな気がします。

ローカルLLM面白いね、今後来そうだね

自分のPC上で動くってのが面白くて良いです。

そして、ローカルに限定できるので、

セキュリティ的に生成AIが難しいという環境でも使えるようになりそう。

(ここはマシンとLLM両面の性能次第ですが。)

Discussion