Llama 3.1 405Bを体験してみた

はじめに

Meta社からLlama 3.1 405Bがリリースされたとアナウンスがありました!

GPT-4oやClaude 3.5 Sonnetと同程度の精度がでそうです。

オンプレやプライベートクラウドでLLMを動かしている企業さんにとって切り替えの検討対象になるかもしれませんね。

アナウンスを読み解く

Llama 3.1:オープンソースAIの新たな時代を切り拓く

Llama 3.1は、Meta社が提供する、オープンソースかつ業界最高峰の性能を誇る大規模言語モデルです。Meta社は、オープンソースAIの普及に積極的に取り組んでおり、CEOのマーク・ザッカーバーグ氏は、オープンソースであることこそが開発者、Meta社、そして世界にとって有益であると述べています。

Llama 3.1の主な特徴は以下の通りです。

オープンソース:

開発者はモデルの重みをダウンロードし、ニーズやアプリケーションに合わせてカスタマイズ、新たなデータセットでのトレーニング、追加のファインチューニングを行うことができます。

高性能:

Llama 3.1 405Bは、一般的な知識、操縦性、数学、ツール使用、多言語翻訳において、GPT-4、GPT-4o、Claude 3.5 Sonnetなどの主要なAIモデルに匹敵する性能を備えています。

多言語対応:

8Bおよび70Bモデルは、多言語に対応し、128Kという大幅に長いコンテキスト長を備えています。

ツール使用と推論能力の向上:

最新モデルは、長文要約、多言語会話エージェント、コーディングアシスタントなどの高度なユースケースをサポートします。

モデルの蒸留と合成データ生成:

405Bモデルは、小規模モデルの改善とトレーニングを可能にする合成データ生成、およびこの規模のオープンソースではこれまで達成できなかったモデル蒸留などの新しいアプリケーションやモデリングパラダイムに火をつけるでしょう。

Llamaエコシステムの構築と発展

Meta社は、Llamaモデルを単なる基盤モデルとして提供するのではなく、外部ツール呼び出しなどの複数のコンポーネントを統合できる包括的なシステムとして開発しました。

Llama System:

開発者が独自のビジョンに沿ったカスタムサービスを設計・作成できる柔軟性を提供するために、コアLLMの外部にコンポーネントを組み込むという考え方が導入されました。

Llama Guard 3:

多言語に対応した安全モデル。

Prompt Guard:

プロンプトインジェクションフィルター。

Llama Stack:

ツールチェーンコンポーネント(ファインチューニング、合成データ生成)やエージェントアプリケーションの構築方法に関する標準化されたインターフェース。

オープンソースAIの未来:

イノベーションと責任ある発展

Llama 3.1のリリースは、オープンソースAIが業界標準となるための大きな一歩となります。

イノベーションの促進:

開発者は、Llamaモデルを活用することで、多言語機能やコンテキスト長の増加を利用した、より便利で新しいエクスペリエンスを構築することができます。

責任あるAI開発:

Meta社は、潜在的なリスクを特定、評価、軽減するために、レッドチームによる展開前のリスク発見演習や、安全性のファインチューニングなど、いくつかの対策を講じています。

Llama 3.1は、オープンソースAIの可能性を最大限に引き出し、開発者、企業、そして社会全体に利益をもたらす可能性を秘めています。

今後の展望

Meta社は、今後もLlamaモデルの開発を続け、デバイスに優しいサイズ、追加のモダリティ、エージェントプラットフォームレイヤーへの投資など、新たな分野を探求していくとしています。

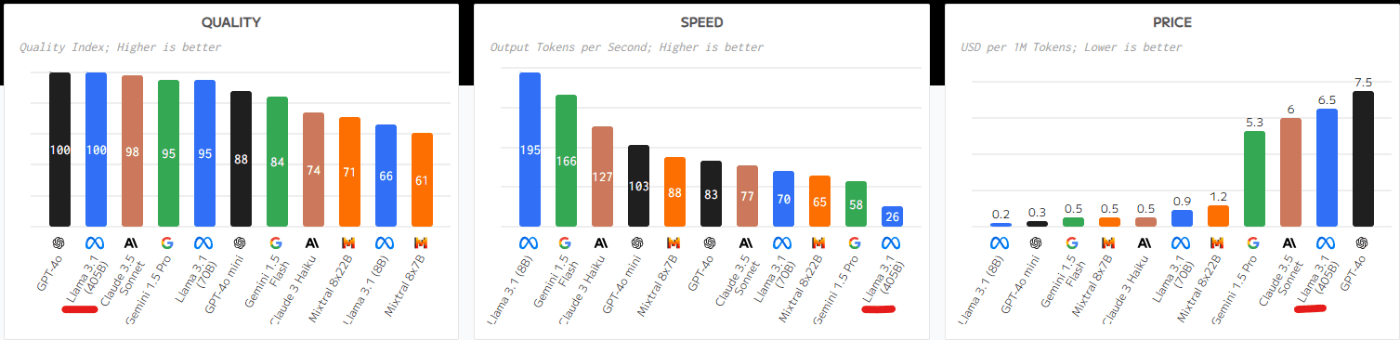

他のLLMと比較してみる

比較サイトで他のLLMと比較してみましょう。

GPT-4oやClaude 3.5 Sonnetと同じレベルの精度がでるとなっていますね。

体験してみる(Open Routerを使う)

OpenRouterは、ユーザーが複数のAIモデルにアクセスできる統一インターフェースを提供するプラットフォームです。このプラットフォームを使用することで、GPT、LLama、Claude、Command-Rなどの様々なAIモデルを簡単に利用することができます。

じゃんけんゲームをコーディングするように依頼してみました。

体験してみる(Dify->Open Routerを使う)

もちろんDify経由でもLlama 3.1 405Bを使用することができます。

同じく、じゃんけんゲームを今ディングするように依頼してみました。

2024/7/24時点では、SaaS版のDifyのみでLlama 3.1 405Bが使用できました。(GitHubに公開されているv0.6.15ではまだ使用できませんでした)

Open Routerのチャットボットより速い?

体験してみる(Perplexity PRO版を使う)

Perplexityの対応が早く、使用することができます。

設定画面で明示的に切り替えることができます。

実際Perplexityでアクセンチュアについて質問してみました。

さいごに

Llama 3.1 405Bの紹介と実際に使ってみた様子を記事にしました。

冒頭にも書きましたが、オンプレやプライベートクラウドでLLMを運用されている企業さんにとっては切り替えの検討対象になるかもしれません。

Discussion