Copilot+PCでLlama3.2を動かしてみる!

はじめに

2024年9月25日(現地時間)にmeta社からLlama3.2が発表されました。

特徴

多様なモデルサイズ

軽量なテキストモデル(1B、3B)

エッジデバイスやモバイルデバイスに最適化され、要約、指示実行、リライトなどのタスクをローカルで実行できます。

ビジョンLLM(11B、90B)

画像理解、キャプション生成、視覚的なグラウンディングタスクをサポートします。

オープン性とカスタマイズ性

開発者はLlama 3.2をダウンロードし、商用利用を含む幅広い用途で自由に使用・変更できます。

torchtune を使用したカスタムアプリケーションの微調整や、 torchchat を使用したローカル展開が可能です。

エコシステム

Qualcomm、MediaTek、Armなどのパートナー企業との協力により、幅広いハードウェアおよびソフトウェア環境での利用が可能です。

AWS、Databricks、Dell Technologiesなどのパートナー企業が、Llama Stackディストリビューションを提供し、エンタープライズレベルでの導入を支援します。

Llama 3.2の革新的なポイント

エッジAIの進化: 軽量モデルにより、デバイス上で高速かつ低遅延なAI処理が可能になり、プライバシー保護にも貢献します。

ビジョンと言語の融合

画像とテキストの両方を理解するモデルにより、より複雑で高度なタスクを処理できます。

オープンソースによるイノベーションの加速

開発者コミュニティへの貢献を通じて、AI技術の進歩を促進します。

Copilot+PC上でOllamaで使ってみる

それでは、実際にLlama3.2を使ってみましょう。

今回はいつものOllamaを活用します。

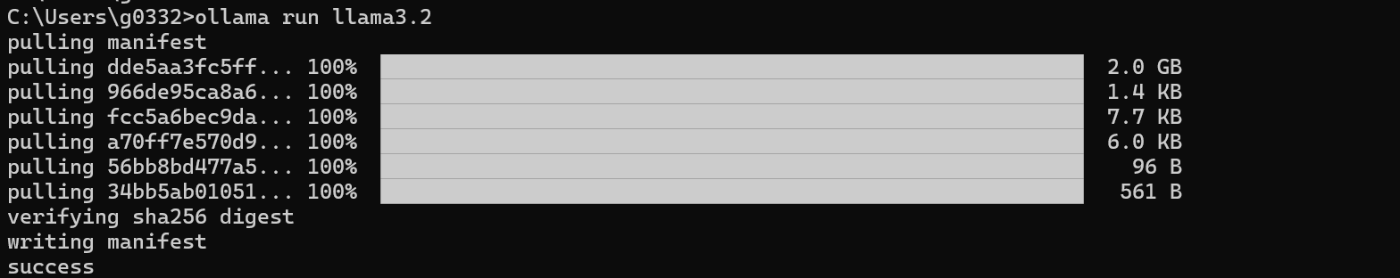

下記コマンドでllama3.2(3B)を実行できます。1Bを実行したい場合は、

ollama run llama3.2

ollama run llama3.2:1b

それではLlama3.2に質問してみましょう。

Please tell me three recomended places in Sapporo.

結構軽快に動きますね。

ただ、わかってはいましたが、NPUは使われずでした。

NPUをバシバシつかったLLMというかSLMを使えると夢広がるのになぁ。

おわりに

いかがでしたか。Llamaも日々進化していますね。引き続き生成AI界隈を追っていけたらと思います!

Discussion