VirtualBoxにOracle Database 19c RACを構築(前編)

はじめに

自己学習として、19cのRAC(Real Application Clusters)を構築してみました。

学習記録として手順を残します。少しでも皆さんの参考になれば幸いです(ミスがあれば指摘をお願いします)。

以下のサイトを参考に手順を作成しました。

記事の前提

・Linux、Oracle、VirtualBoxについて、基本的な操作はできるものとします。

・RACが構築できることを優先しています。手順はあくまで参考程度にして下さい。

1. 全体像

仮想マシン(VM)

2つのノードとDNSサーバの計3つからなります。

| VM名 | ホスト名 | OS | メモリ | ディスク | CPU |

|---|---|---|---|---|---|

| node1_rac19c | node1.rac19c | Oracle Linux 7.9 | 10GB | 80GB | 4 |

| node2_rac19c | node2.rac19c | Oracle Linux 7.9 | 10GB | 80GB | 4 |

| dns_rac19c | dns.rac19c | Oracle Linux 7.9 | 2GB | 80GB | 2 |

※dns_rac19cのディスクが80GBなのは、node1_rac19cのクローンを使用するからです。本来、ここまでディスクは要りません。

ネットワーク構成

| ホスト名 | 接続名 | IPアドレス | 割り当て | 通信用途 |

|---|---|---|---|---|

| node1.rac19c | enp0s3 | (DHCP) | NAT | ゲストOS/外部間 |

| enp0s8 | 192.168.56.101/24 | ホストオンリーアダプター | ホスト/ゲストOS間 | |

| enp0s9 | 192.168.100.101/24 | 内部ネットワーク | ノード間 | |

| node2.rac19c | enp0s3 | (DHCP) | NAT | ゲストOS/外部間 |

| enp0s8 | 192.168.56.102/24 | ホストオンリーアダプター | ホスト/ゲストOS間 | |

| enp0s9 | 192.168.100.102/24 | 内部ネットワーク | ノード間 | |

| dns.rac19c | enp0s3 | (DHCP) | NAT | ゲストOS/外部間 |

| enp0s8 | 192.168.56.254/24 | ホストオンリーアダプター | ホスト/ゲストOS間 |

SCAN構成

| SCAN名 | クラスタ名 | ポート | IPアドレス |

|---|---|---|---|

| scan.rac19c | cluster-rac19c | 1521 | 192.168.56.201 |

| 192.168.56.202 | |||

| 192.168.56.203 |

共有ディスク

| 配置フォルダ | 仮想ディスク名 | サイズ | ディスクグループ | デバイス名(ゲストOS) |

|---|---|---|---|---|

| C:\VBox\shared_disk | SharedDisk1.vdi | 50GB | DATA | sdb |

| SharedDisk2.vdi | 50GB | FRA | sdc |

2. 仮想マシン(VM)の作成及びOSインストール

2-1. VM作成

node1用のVMを作成していきます。

ちなみに、node2とDNSサーバは、node1のVMのクローンを使って構築します。

-

[新規] を選択

-

名前に「node1_rac19c」を記入、タイプは「Linux」を選択 > [次へ] を選択

-

メモリは「10240MB」、CPUは「4」 > [次へ] を選択

-

ディスクサイズ「80GB」 > [次へ] を選択

確認画面が表示されたら、[完了] を選択します。

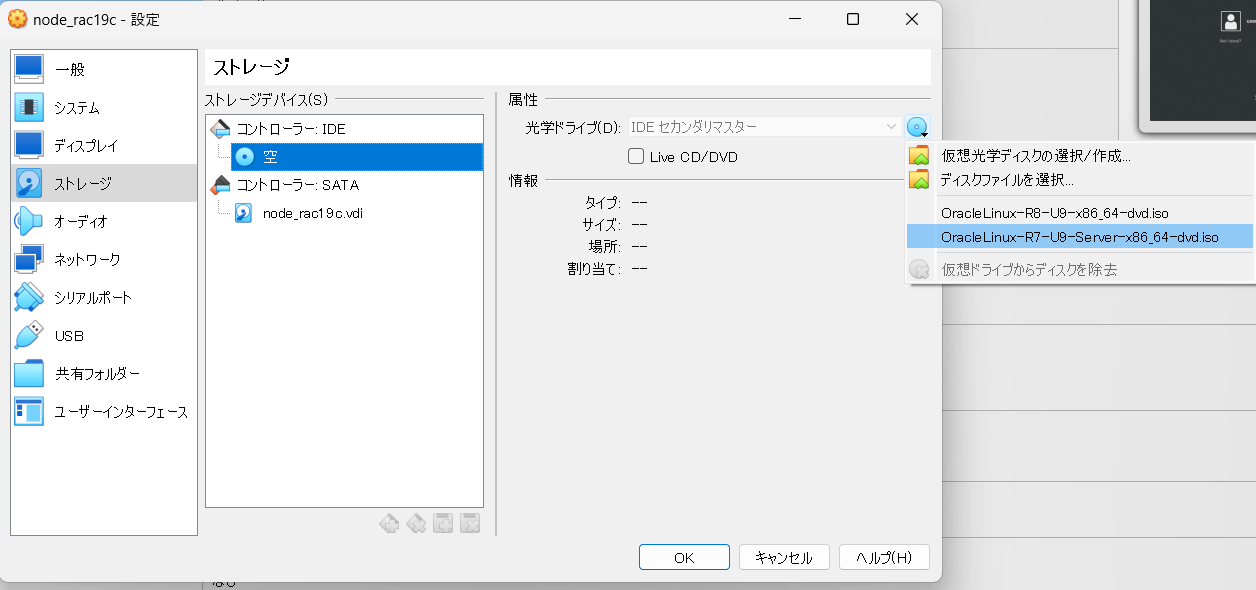

2-2. OSインストール準備

以下のサイトから、OSのISOイメージをダウンロードします

OracleLinux-R7-U9-Server-x86_64-dvd.iso

-

[設定] > [ストレージ] > CD-ROMにOSのISOイメージを配置します

-

[ネットワーク] > [アダプター1] > NATが設定済みであることを確認

-

[アダプター2] > [ネットワークアダプターを有効化] [ホストオンリーアダプター] を選択

-

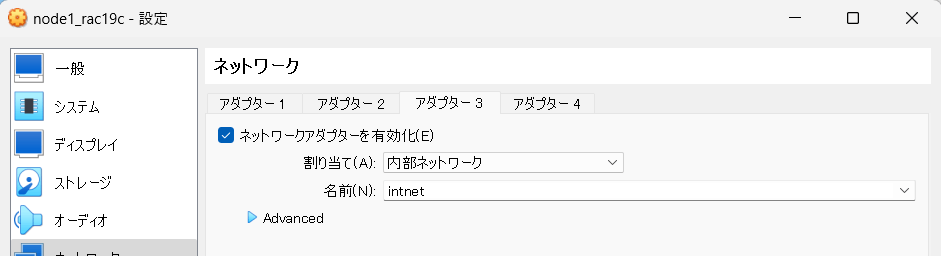

[アダプター3] > [ネットワークアダプターを有効化] [内部ネットワーク] を選択

[OK] を選択し、ホストOSでの設定は完了です。

次は、VMを起動します。

2-3. OSインストール

-

デフォルトの「English」のまま、[Continue] をクリック

-

DATE & TIME > 「Asia」「Tokyo」に変更

-

KEYBOARD LAYOUT > 「Japanese」を追加

-

「Japanese」を選択後、画面左下の「^」マークを使用して、「Japanese」を一番上に

-

LANGUAGE SUPPORT > [日本語(日本)] を選択

-

SOFTWARE SELECTION > [Server with GUI] を選択

-

INSTALLATION DESTINATION > 開いて特に何もせず閉じればOK

-

NERWORK & HOSTNAME > enp0s3 > [ON] にします

-

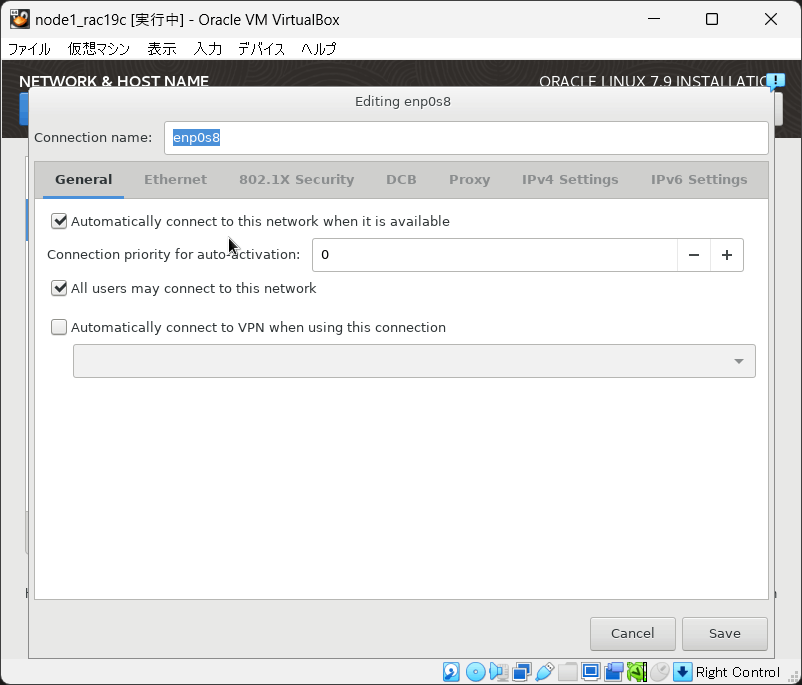

[Configure] > [General] > [Connect automatically with priority] にチェック > [Save]

-

enp0s8 > [ON] にします

-

[Configure] > [General] > [Connect automatically with priority] にチェック

-

[Method] を「Manual」に変更。「192.168.56.101」「24」を入力。> [Save]

-

enp0s9 > [ON] にします

-

[Configure] > [General] > [Connect automatically with priority] にチェック

-

[Method] を「Manual」に変更。「192.168.100.101」「24」を入力。> [Save]

-

[Host Name] に「node1.rac19c」を入力 > [Apply]

-

[Begin Installation] をクリック

-

ROOT PASSWORD > 任意のパスワードを入力

-

CREATE USER > 任意のユーザーを作成

インストール完了を待ちます。

-

インストールが完了したら、[Reboot] をクリック

-

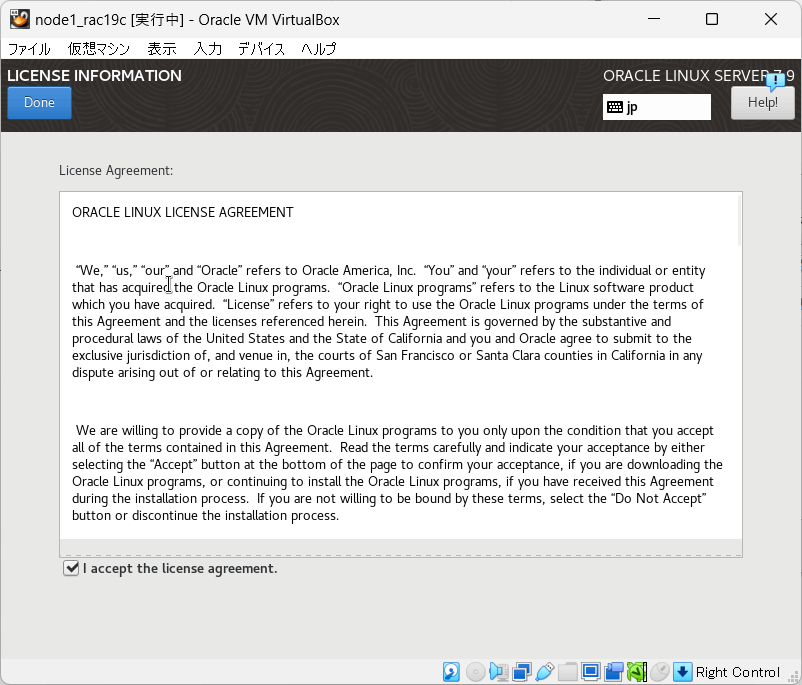

License Information > [I acceot the license agreement] を選択

-

[FINISH CONFIGURATION] をクリック

-

作成したユーザーでログインできるようになります(3-3.でログインが必要です)

3. DNSサーバ構築

3-1. クローンの作成

node1のクローンをDNSサーバとして使います。

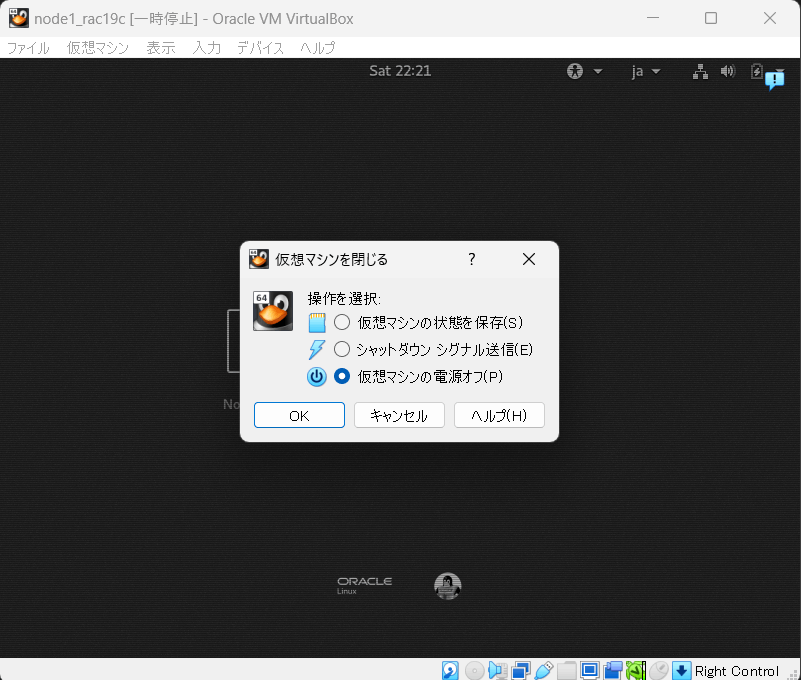

まず、node1のVMを停止します。

- [スナップショット]をクリック

※この写真だとVMが停止してないですがミスです

- [クローン] をクリック

- 名前に「dns_rac19c」を入力し、 [すべてのネットワークアダプターでMACアドレスを生成] を選択 > [次へ]

- [すべてをクローン] > [完了]

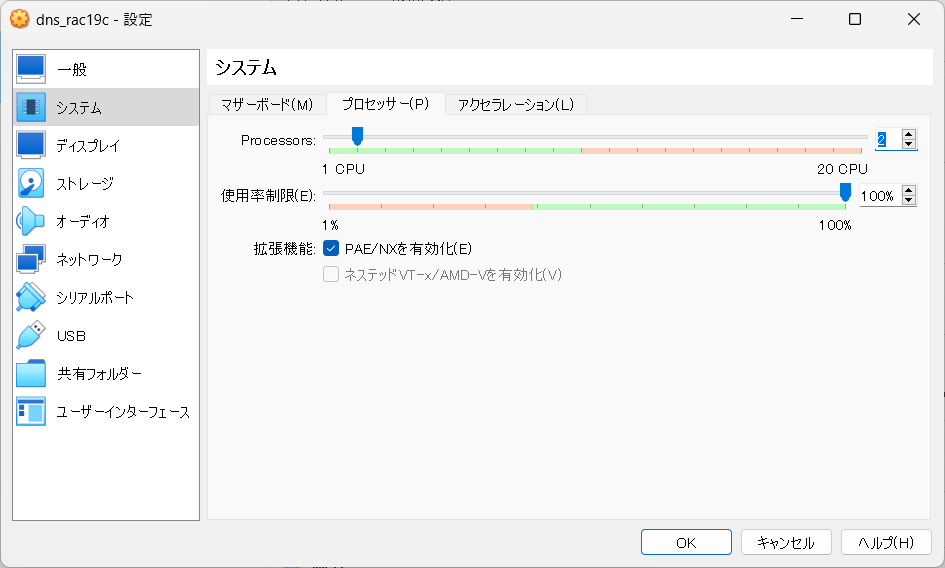

3-2. ハードウェアの設定変更

-

[システム] > メモリのサイズを「2048MB」に書き換える

-

CPUを「2」に書き換える > [OK]

3-3. ネットワークの設定変更

- [ネットワーク] > [アダプター3] > [ネットワークアダプターを有効化] のチェックを外す

dns_rac19cを起動して、GUIで設定作業をします。

ネットワークの設定は、コマンドでもできますが、今回はGUIでやります。

-

[Applications] > [System Tools] > [Settings]

-

[Network]

-

enp0s8を [OFF] に切り替える

-

IPアドレスを「192.168.56.254」に変更 > [Apply]

-

enp0s8を [ON] に切り替える

3-4. /etc/hostname の書き換え

クローン元の「node1.rac19c」が記載されているので、「dns.rac19c」に書き換えます。

vi /etc/hostname

dns.rac19c

OSを再起動します。

reboot

再起動後、ホスト名が「dns.rac19c」になります。

3-5. /etc/hostsの設定

IPアドレスとホスト名の情報を追記します。

vi /etc/hosts

192.168.56.101 node1.rac19c rac1

192.168.56.102 node2.rac19c rac2

192.168.56.111 node1-vip.rac19c rac1-vip

192.168.56.112 node2-vip.rac19c rac2-vip

192.168.56.201 scan.rac19c scan

192.168.56.202 scan.rac19c scan

192.168.56.203 scan.rac19c scan

192.168.56.254 dns.rac19c dns

3-6. dnsmasqパッケージのインストール

rpm -q dnsmasqで確認してインストールされていなかった場合、yumでインストールします。

私が試した時は、既にインストールされていました。

rpm -q dnsmasq

yum install -y dnsmasq

3-7. dnsmasqサービスの有効化

statusを確認した結果として、Active: active (running) が出力されることを確認します。

systemctl enable dnsmasq.service

systemctl start dnsmasq.service

systemctl status dnsmasq.service

出力例:

[root@dns ~]# systemctl status dnsmasq.service

● dnsmasq.service - DNS caching server.

Loaded: loaded (/usr/lib/systemd/system/dnsmasq.service; enabled; vendor preset: disabled)

Active: active (running) since Fri 2024-03-15 21:26:36 JST; 1min 25s ago

(以下省略)

dnsmasqサービスの有効化に失敗する場合

ポート53のリスニングソケットを作成できず、dnsmasqサービスの有効化に失敗した場合、

Dec 22 11:56:58 ol79n23.domain dnsmasq[13647]: dnsmasq: failed to create listening socket for port 53: Address already in use

/etc/dnsmasq.confファイルに以下の2行を追記して、OSを再起動(reboot)してください。

except-interface=virbr0

bind-interfaces

3-8. firewallの無効化

systemctl stop firewalld

systemctl disable firewalld

firewall-cmd --state

以下が表示されること

not runnning

【その他の手順】指定したポートを解放する

紹介した手順では、firewallそのものを無効化しましたが、ポートを指定して開放することもできます(本来この方がセキュリティ上望ましいと思います)

firewall-cmd --add-port 53/udp

以上で、DNSサーバの構築は完了です。

起動したままで問題ありません。

4. RAC構築作業準備

4-1. 作業用ディレクトリを作成

バイナリを配置する場所を、/tmp/work/にします。

mkdir -p /tmp/work/

chmod 777 /tmp/work/

ls -ld /tmp/work/

cd /tmp/work/;pwd

4-2. ファイルの配置

Tera TermのSSH SCP機能などを使って、以下のファイルを配置してください。

- LINUX.X64_193000_db_home.zip

- LINUX.X64_193000_grid_home.zip

- compat-libstdc++-33-3.2.3-72.el7.x86_64.rpm

▽ ダウンロードサイト

ファイルが正常か確認するためにハッシュ値チェックします。値が返ってくれば正常です。

sha256sum LINUX.X64_193000_db_home.zip | grep -i ba8329c757133da313ed3b6d7f86c5ac42cd9970a28bf2e6233f3235233aa8d8

sha256sum LINUX.X64_193000_grid_home.zip | grep -i d668002664d9399cf61eb03c0d1e3687121fc890b1ddd50b35dcbe13c5307d2e

5. システム時刻同期の設定

今回はCTSS(Cluster Time Synchronization Service)を使用するため、NTPの設定を無効化します。ntpdサービスとchronydサービスを停止することで、NTPの設定を無効化します。

5-1. ntpdサービスの停止

systemctl status ntpd

ls -l /etc/ntp.conf

ls -l /var/run/ntpd.pid

※サービスが起動していた場合、以下を実行。

systemctl stop ntpd

systemctl disable ntpd

※設定ファイルが存在していた場合、リネームするか削除します。

5-2. chronydサービスの停止

systemctl status chronyd

ls -l /etc/chrony.con*

mv /etc/chrony.conf /etc/chrony.conf.org

ls -l /etc/chrony.con*

※サービスが起動していたら以下を実行。

systemctl stop chronyd

systemctl disable chronyd

※今回、設定ファイルが存在したため、リネームしました。

6. OS設定

6-1. SELinuxの設定

SELINUXの値をdisabledにします。

grep "^SELINUX=" /etc/selinux/config

sed -i s/SELINUX=enforcing/SELINUX=disabled/ /etc/selinux/config

grep "SELINUX=disabled" /etc/selinux/config

6-2. Oracle Preinstallation RPM によるOS設定

▼ [設定] > [ストレージ] > CD-ROMにOSのISOイメージを配置します(OSインストール準備と同じ要領)

CD-ROMをマウント

mount -t iso9660 /dev/cdrom /mnt

ls /mnt

出力例:

[root@node1 work]# ls /mnt

addons EFI EULA GPL images isolinux LiveOS Packages RELEASE-NOTES-U9-en RELEASE-NOTES-U9-en.html repodata RPM-GPG-KEY RPM-GPG-KEY-oracle TRANS.TBL

yumリポジトリの設定します。

cat >> /etc/yum.repos.d/ol-dvd.repo <<EOF

[ol-dvd]

name=ol-dvd

baseurl=file:///mnt

enabled=1

gpgc=heck0

EOF

不要なyumリポジトリを無効化します。

yum repolistを実行し、ol-dvdだけが表示されることを確認します。

yum-config-manager -q --disable 'ol7*'

yum repolist

Oracle Preinstallation RPMをインストールします。

yum list | grep preinstall

yum install -y oracle-database-preinstall-19c.x86_64

GPG公開キーの影響で実行に失敗する場合

インストールするパッケージのGPG公開キーがインストールされていないという問題が発生した場合は、rpm --import /mnt/RPM-GPG-KEYで対応します。

[root@node1 work]# yum install oracle-database-preinstall-19c.x86_64

Loaded plugins: langpacks, ulninfo

You have enabled checking of packages via GPG keys. This is a good thing.

However, you do not have any GPG public keys installed. You need to download

the keys for packages you wish to install and install them.

You can do that by running the command:

rpm --import public.gpg.key

Alternatively you can specify the url to the key you would like to use

for a repository in the 'gpgkey' option in a repository section and yum

will install it for you.

For more information contact your distribution or package provider.

Problem repository: ol-dvd

[root@node1 work]#

[root@node1 work]# ls -l /mnt/RPM-GPG-KEY

-rw-r--r--. 1 root root 1011 May 29 2021 /mnt/RPM-GPG-KEY

[root@node1 work]#

[root@node1 work]# rpm --import /mnt/RPM-GPG-KEY

[root@node1 work]#

6-3. Zeroconfの設定確認

NOZEROCONF=yesであることを確認

※Oracle Preinstallation RPMで設定済み

cat /etc/sysconfig/network

6-4. 透過的なHugePages無効化の確認

always madvise [never]であることを確認

※Oracle Preinstallation RPMで設定済み

cat /sys/kernel/mm/transparent_hugepage/enabled

6-5. パッケージインストール

※Oracle Preinstallation RPMで設定済みだが、不足している分を手動でインストール

(Oracle Preinstallation RPMを使っているのに、Oracleインストールに必要なRPMパッケージがインストールしきれない原因が分かる方がいれば教えて欲しいです...)

yum install -y compat-libstdc++-33-3.2.3-72.el7.x86_64.rpm

yum install -y elfutils-libelf-devel

yum install -y fontconfig-devel

yum install -y libdtrace-ctf-devel

yum install -y libXrender-devel

yum install -y python-configshell

yum install -y python-rtslib

yum install -y targetcli

compat-libstdc++パッケージについて

インストールメディアを配置しているはずですが、compat-libstdc++パッケージだけは利用できない状況でした。そのため、4-2.であらかじめパッケージをダウンロードしています。

[root@node1 work]# yum install -y compat-libstdc++

Loaded plugins: langpacks, ulninfo

No package compat-libstdc++ available.

Error: Nothing to do

パッケージインストール後、6-2.で配置したISOイメージを削除する

▼ [仮想ドライブからディスクを除去] を選択

6-6. OSグループとユーザーの作成

※Oracle Preinstallation RPMで設定済みだが、不足している分を手動で作成

groupadd -g 54327 asmdba

groupadd -g 54328 asmoper

groupadd -g 54329 asmadmin

6-7. Oracle Grid Infrastructure用 OSユーザーの作成

useradd -u 1001 -g oinstall -G asmadmin,asmdba,asmoper,racdba grid

passwd grid

6-8. Oracle Database用 OSユーザーの作成

※Oracle Preinstallation RPMでユーザー作成済みだが、グループ属性の変更のみを手動で作成

usermod -g oinstall -G dba,oper,backupdba,dgdba,kmdba,asmdba,racdba oracle

passwd oracle

6-9. OSグループとユーザーの作成確認

- Gridユーザー

id grid

以下が表示されること

uid=1001(grid) gid=54321(oinstall) groups=54321(oinstall),54330(racdba),54327(asmdba),54328(asmoper),54329(asmadmin)

- Oracleユーザー

id oracle

以下が表示されること

uid=54321(oracle) gid=54321(oinstall) groups=54321(oinstall),54322(dba),54323(oper),54324(backupdba),54325(dgdba),54326(kmdba),54330(racdba),54327(asmdba)

6-10. カーネル・パラメータの設定確認

※Oracle Preinstallation RPMで設定済み

cat /etc/sysctl.conf | grep -v '#' | grep -v '^[[:space:]]*$'

6-11. リソース制限の追加設定

※Oracle Preinstallation RPMで設定済みだが、不足している分を手動で追記

vi /etc/security/limits.d/oracle-database-preinstall-19c.conf

grid soft nproc 2047

grid hard nproc 16384

grid soft nofile 1024

grid hard nofile 65536

grid soft stack 10240

grid hard stack 32768

6-12. ディレクトリの作成

mkdir -p /u01/app/grid

mkdir -p /u01/app/oracle

mkdir -p /u01/app/19.3.0/grid

mkdir -p /u01/app/oraInventory

mkdir -p /u01/app/oracle/product/19.3.0/dbhome_1

chown -R grid:oinstall /u01

chown -R oracle:oinstall /u01/app/oracle

chown -R grid:oinstall /u01/app/oraInventory

chmod -R 775 /u01

6-13. .bash_profileの設定

- Gridユーザー

su - grid

$ vi ~/.bash_profile

以下を追記

umask 022

export ORACLE_BASE=/u01/app/grid

export ORACLE_HOME=/u01/app/19.3.0/grid

反映させます。

$ . ~/.bash_profile

- Oracleユーザー

su - oracle

$ vi ~/.bash_profile

以下を追記

umask 022

export ORACLE_BASE=/u01/app/oracle

export ORACLE_HOME=/u01/app/oracle/product/19.3.0/dbhome_1

反映させます。

$ . ~/.bash_profile

6-14. firewallの無効化

rootに戻り実行します。

systemctl stop firewalld

systemctl disable firewalld

firewall-cmd --state

以下が表示されること

[root@node1 ~]# firewall-cmd --state

not running

6-15. /etc/resolv.confの設定

DNSの設定に関するファイルです。

vi /etc/resolv.conf

以下の内容に書き換えます。

# Generated by NetworkManager

search rac19c

nameserver 192.168.56.254

[main]の下に「dns=none」を追記。

vi /etc/NetworkManager/NetworkManager.conf

[main]

dns=none

#plugins=ifcfg-rh,ibft

systemctl restart NetworkManager

▽ 6-15.で何をしているのか詳しく知りたい人向け

6-16. /etc/hostsの設定

IPアドレス、ホスト名、別名を追記。

vi /etc/hosts

192.168.56.101 node1.rac19c rac1

192.168.56.102 node2.rac19c rac2

192.168.56.111 node1-vip.rac19c rac1-vip

192.168.56.112 node2-vip.rac19c rac2-vip

6-17. 名前解決の確認

** server can't find <ホスト名>: NXDOMAINのようなエラーが出力されないこと。

正常に値が返ってこない場合、飛ばしている手順があるか、DNSサーバが起動していない可能性が高いです。

nslookup node1.rac19c

nslookup node2.rac19c

nslookup node1-vip.rac19c

nslookup node2-vip.rac19c

nslookup scan.rac19c

nslookup dns.rac19c

出力例:

[root@node1 work]# nslookup node1.rac19c

Server: 192.168.56.254

Address: 192.168.56.254#53

Name: node1.rac19c

Address: 192.168.56.101

VMを停止します。

7. 仮想ディスクの設定

7-1. 仮想ディスクの作成

-

[設定] > [ストレージ] > [ハードディスクの追加] を選択

-

[作成] を選択

-

[VDI] を選択 > [次へ] を選択

-

[Pre-allocate Full Size] を選択 > [次へ] を選択

-

「C:\VBox\shared_disk\SharedDisk1.vdi」と「50.00GB」を入力 > [次へ] を選択

※「C:\VBox\shared_disk\SharedDisk2.vdi」も同様に作成

-

SharedDisk1.vdiを選択した状態で、[Choose]を選択

※SharedDisk2.vdiも同様に選択

-

SharedDisk1.vdiとSharedDisk2.vdiが追加されていることを確認 > [OK] を選択

-

[ツール] > [SharedDisk1.vdi] > [属性] > [タイプ] > [共有可能] > [適用] を選択

※[SharedDisk2.vdi] も同様

-

node1 > [設定] > [ストレージ] > [SharedDisk1.vdi] 、「共有可能」であることを確認

※[SharedDisk2.vdi] も同様

7-2. パーティションの作成

VMを起動します。

現在のパーティション情報を確認

fdisk -l

/dev/sdbと/dev/sdcに、パーティションが作成されていないことが分かります。

[root@node1 ~]# fdisk -l

(中略)

Disk /dev/sdc: 53.7 GB, 53687091200 bytes, 104857600 sectors

Units = sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disk /dev/sdb: 53.7 GB, 53687091200 bytes, 104857600 sectors

Units = sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

(以下省略)

単一パーティションを作成

fdisk /dev/sdb

▼以下の表示に沿って入力してください

[root@node1 ~]# fdisk /dev/sdb

Welcome to fdisk (util-linux 2.32.1).

Changes will remain in memory only, until you decide to write them.

Be careful before using the write command.

Device does not contain a recognized partition table.

Created a new DOS disklabel with disk identifier 0xe895a492.

Command (m for help): n <=====「n」入力し、Enterを押す

Partition type

p primary (0 primary, 0 extended, 4 free)

e extended (container for logical partitions)

Select (default p): <=====Enterを押す

Partition number (1-4, default 1): <=====Enterを押す

First sector (2048-104857599, default 2048): <=====Enterを押す

Last sector, +sectors or +size{K,M,G,T,P} (2048-104857599, default 104857599): <=====Enterを押す

Created a new partition 1 of type 'Linux' and of size 50 GiB.

Command (m for help): w <======「w」入力し、Enterを押す

The partition table has been altered.

Calling ioctl() to re-read partition table.

Syncing disks.

/dev/sdbと同じ要領で、/dev/sdcでも作業をしてください

fdisk /dev/sdc

パーティション情報の確認

fdisk -l

/dev/sdbと/dev/sdcに、パーティションが作成されたことが分かります。

[root@node1 ~]# fdisk -l

(中略)

Disk /dev/sdc: 53.7 GB, 53687091200 bytes, 104857600 sectors

Units = sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disk label type: dos

Disk identifier: 0x9d1e142b

Device Boot Start End Blocks Id System

/dev/sdc1 2048 104857599 52427776 83 Linux

Disk /dev/sdb: 53.7 GB, 53687091200 bytes, 104857600 sectors

Units = sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disk label type: dos

Disk identifier: 0x5f9d14b0

Device Boot Start End Blocks Id System

/dev/sdb1 2048 104857599 52427776 83 Linux

(以下省略)

7-3. udevルールの設定

vi /etc/udev/rules.d/99-oracle.rules

以下の内容を記述します。

KERNEL=="sdb1",ACTION=="add|change",OWNER="grid",GROUP="asmadmin",MODE="0660"

KERNEL=="sdc1",ACTION=="add|change",OWNER="grid",GROUP="asmadmin",MODE="0660"

設定を即時反映します

/sbin/udevadm trigger --type=devices --action=add

ブロック・デバイスのオーナーとパーミッションが正しく設定されていることを確認

ls -la /dev/ | grep asm

出力例:

[root@node1 ~]# ls -la /dev/ | grep asm

brw-rw---- 1 grid asmadmin 8, 17 Mar 16 09:43 sdb1

brw-rw---- 1 grid asmadmin 8, 33 Mar 16 09:43 sdc1

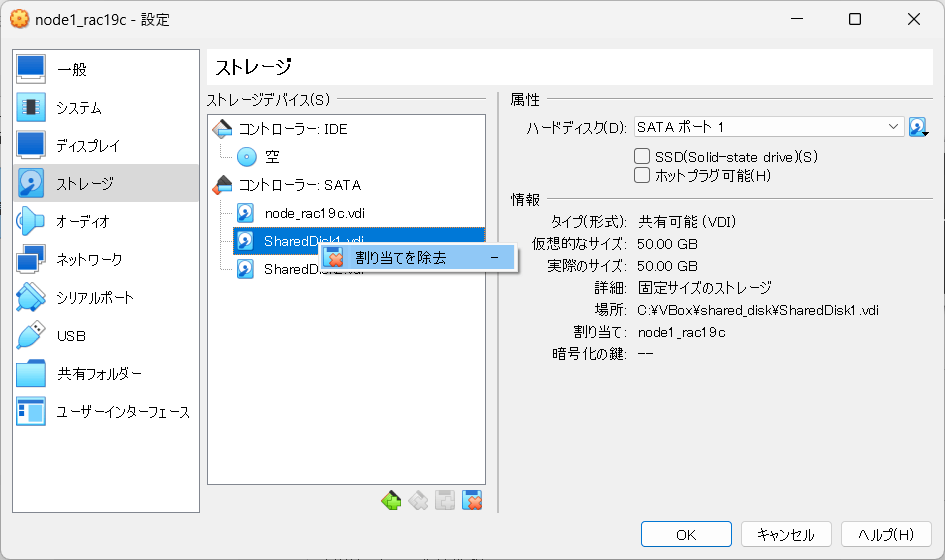

VMを停止します。

クローン作成の前に、仮想ディスクをnode1からデタッチします。

※デタッチするのはSharedDisk1.vdi、SharedDisk2.vdiの2つです。

▼ [設定] > [ストレージ] > ディスクを選択 > [割り当てを除去]

8. node2の作成

8-1. クローンの作成

node1のクローンをnode2として使います。

まず、node1のVMを停止します。

-

[スナップショット]を選択

-

[クローン] を選択

-

名前に「node2_rac19c」を入力、▼ [すべてのネットワークアダプターでMACアドレスを生成] を選択 > [次へ]

-

[すべてをクローン]を選択 > [完了]

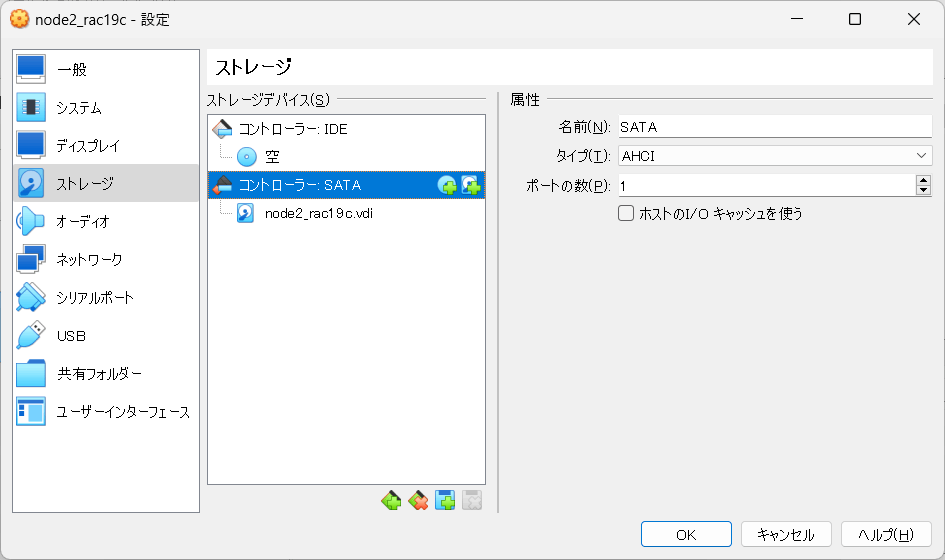

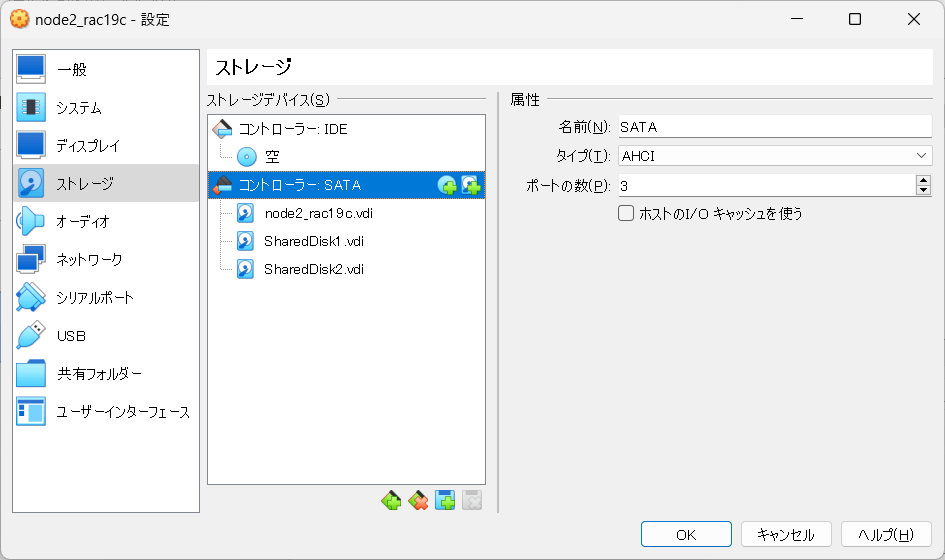

8-2. 仮想ディスクをアタッチ(node1,node2)

node1とnode2のそれぞれで、SharedDisk1.vdiとSharedDisk2.vdiをアタッチします。

手順は紹介済みなので省略します。

8-3. ネットワークの設定変更

node2を起動します。

以降、GUIから設定作業を進めます。

▼ enp0s8、enp0s9を [OFF] に切り替える

▼ enp0s8、enp0s9のIPアドレスをnode2のものに変更

▼ enp0s8、enp0s9を [ON] に切り替える

8-4. /etc/hostnameの書き換え

クローン元の「node1.rac19c」が記載されているので、「node2_rac19c」に書き換えます。

vi /etc/hostname

node2_rac19c

reboot

これでホスト名が変更できました。

続きはこちらへ

Discussion