🕌

Skyvia① ローカル環境からデータを転送する+α

はじめに

前回はSkyviaという製品について調べました。CDCを考慮した差分更新やマッピング機能の柔軟性、Skyvia Agent Applicationを利用することでオンプレミス環境から容易にデータを転送できる(らしい)ということで期待大かなと個人的に思っています。(またUIが個人的に好み...)

今回触ってみてよかったなと思うことは....

- カラムのマッピングが柔軟に設定できてよい(込み入った処理を行うには課金が必要そう..)

- インポートしたデータに対してSQLなどを書くことができる(面白いなぁと思いました)

今回行うこと

毎度おなじみの(毎度おなじみですみません)ローカル環境のcsvデータをSnwoflakeにロードしていきます。またロードしたデータをSkyvia側からSQLで操作してみたいと思います。

今回は下記の公式ドキュメントの手順に倣い実行していきます。

手順

0. Snowflake側で先にテーブルを作成しておきます

1.「NEW」から「import」をクリックします

2.「Source」、「Target」を選択します(Connectionに関しては別途、接続設定を行います)

3. 右の「Add new」から今回実施するジョブの作成を行います。(ローカル環境からSnowflakeにデータを転送するジョブ)

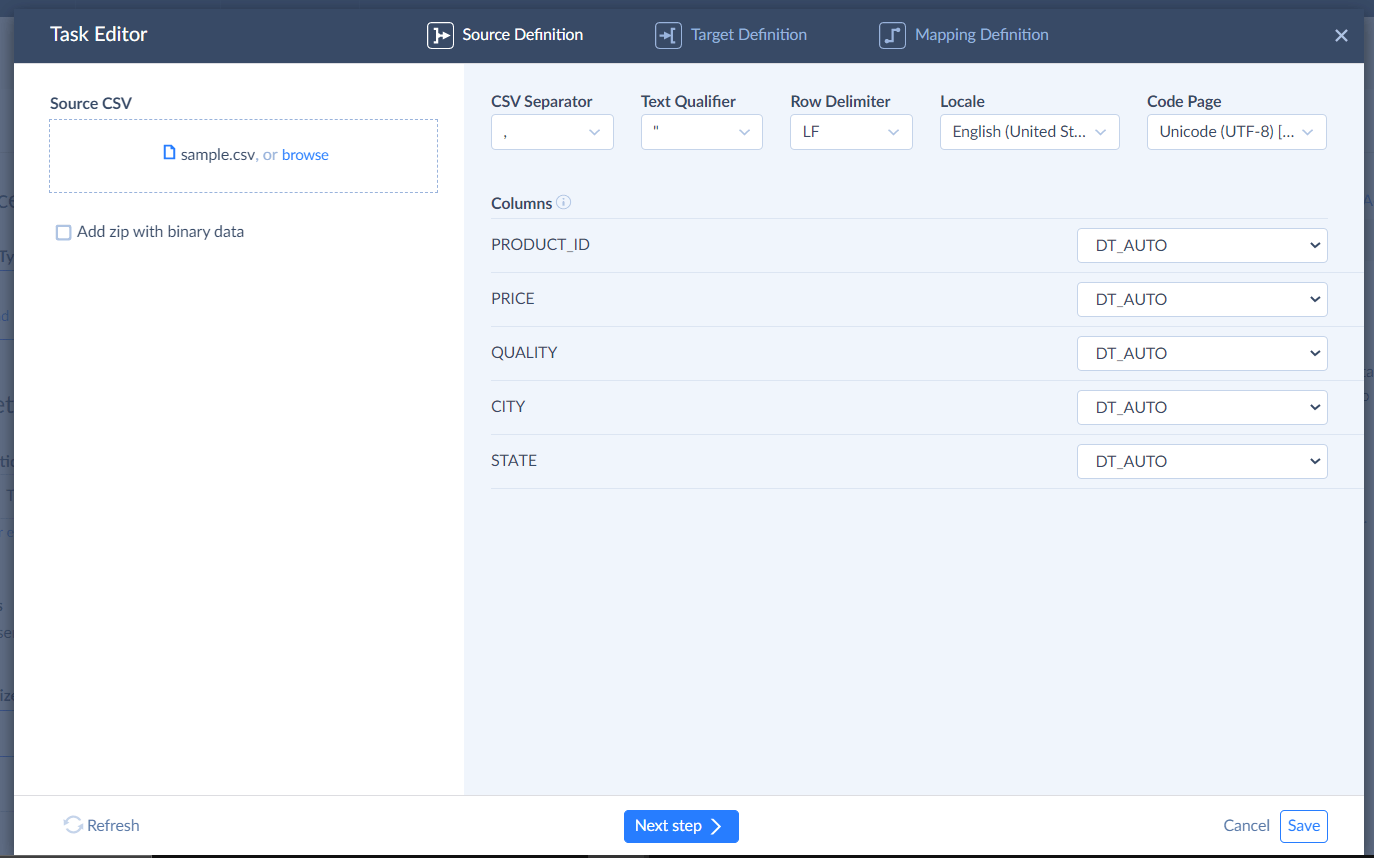

4. csvファイルをインポートします

- 各カラムのデータ型の設定はここで行うことができます

- またロード時の細かな設定もここで行えます

5. データ更新方法の設定を行います

- 「Insert」で今回は実行します

6. 事前にSnowflake側で作成したカラムとのマッピングを行います

- 各カラムに対して抽出時に様々な設定を行うことができます。

- 今回は

priceカラムに1.1をかけています - (Expression Mappingは無課金ではできないようです....)

7. パッケージの保存を行います

- 右上の「Save」をクリックします

8. 作成したjobを実行します

- 右上の「Run」をクリックし、ジョブの実行を行います

- (時間がかかりますがじっと待機するかほかの作業をします)

※ 「Monitor」タグでは実行の途中経過を確認できます

※ 「Log」では過去のジョブ履歴を確認できます

9. Snowflake側でデータを確認します

おまけ

-

インポート行ったデータに対して、SQLを書きます(ETLツールなのにかけちゃいます)

-

「Builder」でも簡単な分析が可能です

-

また「Builder」で作成したロジックもSQLで確認ができます

-

注意) 課金しないと1日数回しか実行できない模様です

Discussion