AI関係で今日(2024/04/06)気になったweb記事 or SNS投稿を紹介する。

AI系は本当に情報更新が多すぎますよね。私は情報ついていけてないと無意味に不安になります。

この記事では私が今日確認して気になった記事や投稿を紹介します。

情報が多いので、一つ一つは結構雑めに自分の中でのまとめを書きました。

自分の中での情報整理の意味合いが大きいので、文章はとても稚拙ですが、ご容赦ください。

気になったものがありましたら、ソースの方を確認していただくような使い方でお願いします。

ReFT

手法の論文: https://arxiv.org/abs/2404.03592

ReFT: https://github.com/stanfordnlp/pyreft

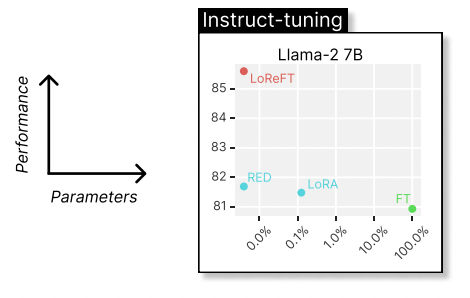

パラメーター効率がいい学習の手法です。 パラメーター効率化の方法はLoreなどが有名ですがそれよりもさらに効率化、高性能かしたということみたいです。

単一の A100 GPU + ReFT を使用して、ChatGPT-3.5-1103 と同等の 7B チャット モデルを 18 分以内にトレーニングできます

とREADMEにあるので中小企業など計算資源があまり多く取れない企業でLLMの学習を試したい時には活用できそう。 論文の中ではLoRAと比べてもかなりパフォーマンスが高そうな結果が出ているが

Command R+

公式: https://docs.cohere.com/docs/command-r-plus

日本語記事: https://hamaruki.com/japanese-version-c4ai-command-r-model-card/

cohereが新たに出した言語モデル。 多言語対応と複雑なRAG対応が売りらしい。 コンテキストウインドウは128k。

複雑なRAG対応というのはつまり、Google検索やWolframといった汎用エージェント界隈で標準的に使われるAPIに対してよく学習済みであるということだと思われる。

LM-DiskANN

twitter: https://twitter.com/penberg/status/1776484508029608125

github: https://github.com/microsoft/DiskANN

RAGアプリケーションで頻繁に使用されるベクトル近似最近傍探索(ANN)の方法について簡単にまとめてくれている。 ANNの手法ではグラフ構造などを用いて効率化する手法などがある。

もちろんANNの精度と速度は基本的にトレードオフの関係にあるので、実際のアプリケーションでの要件を考えて、色々試す必要がある。

Faissなどで実装されている手法もデフォルトで使われている手法以外にもさまざまに、効率化できる部分はありそうなので、検索速度など改善したいと思ったらみてみると良さそう

Discussion